Nada arruina una demostración tecnológica como una muerte accidental. Corría el año 1830 y la ocasión era la inauguración del primer ferrocarril interurbano del mundo, entre Liverpool y Mánchester. Mientras las autoridades deambulaban por el lugar, un parlamentario local, William Huskisson —uno de los políticos británicos más firmemente favorables al ferrocarril— bajó a las vías para estrechar la mano del primer ministro Arthur Wellesley. Huskisson no se dio cuenta de lo rápido que se le venía encima uno de los nuevos trenes —el Rocket, capaz de alcanzar las treinta millas por hora, una velocidad impensable para la época—. Al verlo, entró en pánico y quedó atrapado sobre las vías. Para William Huskisson fue el final del trayecto. La puesta de largo del ferrocarril quedó empañada por una de las primeras muertes ferroviarias de la historia.

La idea de que un transporte tan rápido pudiera pronto estar al alcance de todos era revolucionaria, pero en aquel momento los titulares se centraron en la tragedia provocada por esta nueva y aterradora tecnología. Hoy, con la revolución digital que se ha desarrollado desde la década de 1970 (la Tercera Revolución Industrial) y con el auge de la inteligencia artificial y la biotecnología en la década de 2020 (lo que algunos denominan la Cuarta Revolución Industrial), el mundo vuelve a cambiar más rápido que nunca, y muchas personas sienten que serán ellas las que queden atrapadas en las vías.

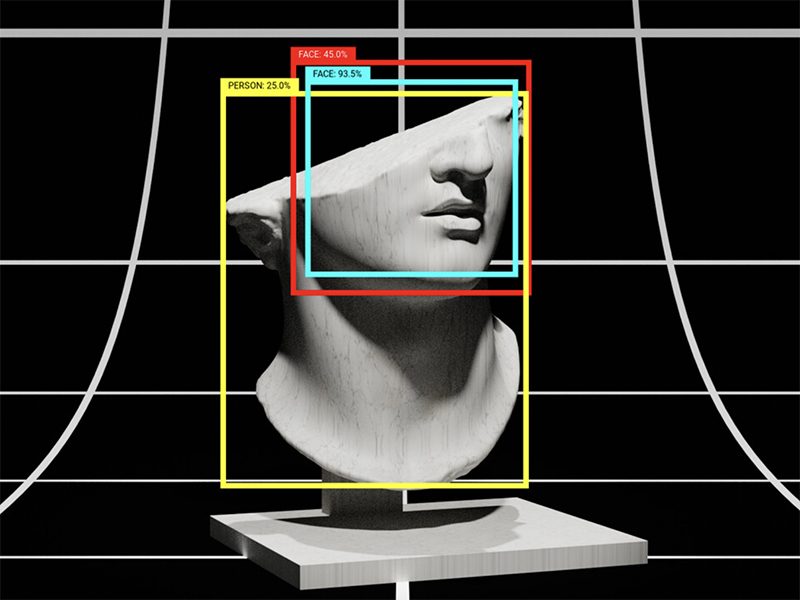

El siglo XXI apenas cuenta con auténticos luditas que pidan dar marcha atrás a la tecnología. Pero bajo la superficie de los prodigios digitales se esconde un mundo de disrupción, convulsión y disenso. Muchas de las tensiones de nuestro tiempo —entre prosperidad e inestabilidad, entre interconexión y atomización, entre progreso y reacción— son, al menos en parte, resultado de estas transformaciones tecnológicas. No es casualidad que el atractivo del populismo haya crecido en un mundo rápidamente reconfigurado y desestabilizado por la innovación. Los avances en productividad y bienestar humano derivados de la revolución de las tecnologías de la información han sido inmensos. Pero tampoco debería sorprendernos que el trayecto haya sido accidentado hasta ahora, quizá incluso más que en revoluciones anteriores, porque esta no trastoca solo límites físicos, sino también mentales y biológicos. Cambia quiénes somos.

Paradójicamente, las raíces de este cambio —una transformación que parece demasiado rápida, demasiado confusa, demasiado caótica— surgieron de lo que parecía un periodo de ralentización y estancamiento. Los años setenta suelen recordarse como una época de malestar. En la política y la cultura, las cruzadas idealistas de los sesenta se apagaron en frustración. En lo económico, la estanflación parecía haberse convertido en la nueva normalidad.

El economista Robert Gordon, en su ambiciosa obra The Rise and Fall of American Growth, relata el siglo extraordinario que va de 1870 a 1970, desde la Edad Dorada hasta la Era del Ordenador, cuando nuevas tecnologías modernizaron la vida estadounidense y sentaron las bases del estilo de vida que hoy asociamos a la clase media en todo el mundo. Fue el Reino Unido quien disfrutó de manera abrumadora los frutos de la primera Revolución Industrial —el vapor, el ferrocarril y los textiles producidos en masa— a partir de finales del siglo XVIII. Y fue Estados Unidos el principal innovador y beneficiario de la Segunda Revolución Industrial desde finales del siglo XIX, con avances en energía, materiales, química y automoción.

Estados Unidos siguió construyendo sobre ese progreso hasta bien entrado el siglo XX, rehaciéndose en beneficio de casi todos los que vivían dentro de sus fronteras. Los estadounidenses alcanzaron esperanzas de vida sin precedentes gracias a nuevos medicamentos. Consumieron alimentos más abundantes y variados producidos por la agricultura industrial. Vivieron en nuevos suburbios y ciudades interconectados por ferrocarriles, autopistas y aerolíneas. Estas transformaciones fueron en gran medida físicas. Se podían ver los incontables coches en las carreteras, los lavavajillas y televisores en los hogares, las ciudades iluminadas por la electrificación, la expansión urbana, las gigantescas cosechadoras recorriendo campos de trigo y maíz. En lo que probablemente sea la mayor hazaña de ingeniería de la historia humana, en 1969 los hombres de la misión Apolo 11 llegaron a la Luna, marcando nuevas cotas del ingenio tecnológico estadounidense.

Sin embargo, en los años siguientes Estados Unidos volvió a poner los pies en la tierra. El crecimiento explosivo de la posguerra fue perdiendo fuelle. Llegar a la Luna fue un logro emocionante, pero el espacio no era una nueva frontera que pudiera realmente poblarse y desarrollarse. En la Tierra, el ritmo del cambio se desaceleró y los estadounidenses se acomodaron a las rutinas monótonas de la vida moderna. La forma de desplazarse al trabajo, de llevar los alimentos a la mesa o de abastecer de energía los hogares cambió poco durante las décadas posteriores. En palabras del economista Tyler Cowen, parecía que Estados Unidos ya se había comido “toda la fruta al alcance de la mano” de la historia moderna. El país había vivido un estallido único impulsado por el aprovechamiento de los combustibles fósiles y la puesta en valor del territorio, junto con una generosa dosis de ingenio humano. Fue una explosión difícil de replicar.

Pese a todo el malestar de los años setenta, aquel periodo resultó ser una etapa de progreso oculto. Una tormenta de cambio tecnológico se estaba gestando silenciosamente en una zona de California que pronto sería conocida como Silicon Valley. Esta revolución no transformaría el paisaje físico como las anteriores; sería una revolución digital, construida sobre bits y bytes invisibles. Pero cambiaría el mundo como nada antes. Las tecnologías de las revoluciones previas alteraron el mundo material; la revolución digital transformaría el mundo mental, ampliando la información, el conocimiento y la capacidad analítica, y con ello nuestra propia definición de lo que significa ser humano. Sea cual sea el impacto cuantitativo de la revolución de la información que estamos viviendo, su impacto cualitativo sobre la psique humana es inmenso y sigue desplegándose.

Los Supersónicos se equivocaron

El auge de internet y de la informática personal suele denominarse la Tercera Revolución Industrial. Esta revolución ha sido a la vez más rápida y más extendida que las dos anteriores y, sin embargo, más sutil, ya que se ha desarrollado en gran medida en el ámbito de la información. Los primeros ordenadores se desarrollaron durante la Segunda Guerra Mundial como herramientas de descifrado de códigos para la inteligencia militar estadounidense y británica. Eran colosos de válvulas de vacío y circuitos que ocupaban salas enteras. Con la invención del chip informático llegaron los primeros ordenadores personales, máquinas compactas fabricadas por empresas como Hewlett-Packard y Xerox.

Lo que hoy llamamos internet no comenzó con empresas privadas, sino con un proyecto del Pentágono, ARPANET, una red diseñada para conectar a investigadores de universidades de la costa oeste con colegas de todo el país. Desde el momento en que entró en funcionamiento, en 1969, ARPANET se fue ramificando de forma constante hacia más universidades y laboratorios durante los años setenta y ochenta. Luego, en 1989, el científico informático británico Tim Berners-Lee, que trabajaba en el laboratorio de física de partículas del CERN en Ginebra, ideó la combinación de sistemas que sustentan la internet moderna: los enlaces de hipertexto que permiten pasar de un texto a otro, los protocolos de control de transmisión que conectan ordenadores de todo tipo a la misma información y los nombres de dominio únicos para cada sitio web. Lo llamó la World Wide Web, aunque al principio solo estaba disponible para los científicos del CERN. Dos años después, mientras todas las miradas estaban puestas en el colapso de la Unión Soviética, se produjo en Ginebra un cambio quizá aún más trascendental, casi en silencio: la Web se abrió al mundo entero, inaugurando la internet tal como la conocemos hoy.

En 1990, ningún país del planeta tenía siquiera al 1% de su población utilizando internet. Hoy, el 93% de los estadounidenses está en línea, al igual que alrededor del 70% de los asiáticos y de los habitantes de Oriente Medio. Incluso en las regiones menos desarrolladas del mundo, África subsahariana y Asia meridional, aproximadamente un tercio de la población usa internet. Cada día se envían más de trescientos mil millones de correos electrónicos desde más de cuatro mil millones de usuarios en todo el mundo. Pensemos en cuántas décadas hicieron falta para que los ferrocarriles se difundieran por el mundo en el siglo XIX, o para que los automóviles se volvieran omnipresentes en el siglo XX. A comienzos del siglo XXI, los ordenadores personales y los teléfonos inteligentes (minicomputadores en nuestros bolsillos) se generalizaron en apenas veinte años. La adopción tecnológica dentro del ecosistema de internet es aún más rápida. Hicieron falta casi cuatro años para que cien millones de personas en todo el mundo usaran Facebook; algo más de dos años para alcanzar esa misma cifra en Instagram; y apenas dos meses para que cien millones de personas empezaran a usar ChatGPT.

Por impresionante que haya sido el paso de lo físico a lo digital, muchos escépticos —incluso algunos dentro de la propia industria— lo consideran una decepción. En palabras, a menudo citadas, de Peter Thiel, fundador de PayPal y Palantir: “Queríamos coches voladores. En su lugar obtuvimos 140 caracteres”. En un nivel superficial, Thiel tiene razón. Estamos muy lejos de la visión del siglo XXI que ofrecía la serie de animación de 1962 Los Supersónicos. Los fans más atentos han señalado que George Jetson, el patriarca de esta arquetípica familia futurista, nació en 2022. Pero el mundo actual no se parece en nada al de Los Supersónicos: no hay coches voladores, ni criadas robóticas conscientes, ni —ni siquiera para Elon Musk— vacaciones interplanetarias.

Y, sin embargo, ¿qué tenemos hoy que Los Supersónicos no tenían? Aunque algunas predicciones fueron acertadas —las videollamadas, por ejemplo—, las implicaciones más profundas de la transición digital no fueron previstas. La tecnología que sustenta nuestra época es radicalmente distinta de las que la precedieron. Ha fomentado una revolución de la mente. Ha ampliado de forma espectacular el acceso a la información, conectando a casi todo el planeta y facilitando la difusión de ideas de todo tipo, tanto buenas como malas.

En lugar de transformar nuestro mundo físico, la revolución de las tecnologías de la información ha creado un mundo completamente nuevo: un mundo digital, lleno de conocimiento universalmente accesible, de la digitalización de casi todas las industrias, de infinitos formatos de entretenimiento y de nuevos tipos de vínculos sociales. Así, aunque los medios de transporte no hayan avanzado como algunos preveían, pensemos en lo que hoy puede hacerse durante un vuelo en avión o un trayecto en tren y que para los viajeros de la década de 1960 habría sido pura ciencia ficción: acceder de inmediato a prácticamente cualquier película, serie de televisión o libro; hablar con un amigo o un ser querido; gestionar el trabajo (si se trata de un empleado de cuello blanco) casi con la misma eficacia que si se estuviera en la oficina.

La calidad de vida ha mejorado de forma sustancial para todos, aunque muchos de los bienes y servicios gratuitos que ha hecho posibles la revolución digital no queden plenamente reflejados en métricas convencionales como el PIB. Pensemos en la industria musical. Entre 2004 y 2008, los ingresos totales por ventas de música cayeron de 12.000 millones de dólares a 7.000 millones. Pero no es que la gente escuchara menos música; simplemente lo hacía de otra manera. En ese mismo periodo, las descargas de canciones individuales aumentaron casi diez veces, pasando de unos 143 millones a 1.400 millones, con las canciones ahora ampliamente accesibles a través de múltiples plataformas digitales.

Del mismo modo, hoy cualquiera con acceso a internet puede perderse en las profundidades de Wikipedia, que en 2023 contenía alrededor de cien veces más información que la Encyclopedia Britannica impresa, durante mucho tiempo la principal fuente de conocimiento general en lengua inglesa desde su primera publicación en 1768 hasta finales del siglo XX. Pero, a diferencia de la Britannicaimpresa, Wikipedia es gratuita. La diferencia en el uso es asombrosa. En 1990, once años antes de que se fundara Wikipedia, se vendieron en todo el mundo 117.000 ejemplares de la Britannica. Hoy, Wikipedia recibe más de 1.500 millones de visitantes únicos cada mes. De hecho, uno de los rasgos más llamativos de esta revolución es la manera en que ha transformado el tiempo de ocio. Solo en 2013, los usuarios de Facebook pasaron colectivamente alrededor de doscientos millones de horas al día en la plataforma. Como han señalado los investigadores Erik Brynjolfsson y Andrew McAfee, se trata de diez veces más horas-persona de las que fueron necesarias para construir el Canal de Panamá. En esta comparación se aprecia un microcosmos del paso de la revolución industrial a la revolución de la información: del ámbito físico a la vida de la mente.

zz

Cada hombre, un rey

Tras la Primera Guerra Mundial, un brillante joven economista llamado John Maynard Keynes describió el mundo de progreso económico y tecnológico que la guerra había destruido. “El habitante de Londres podía pedir por teléfono, mientras sorbía su té matinal en la cama, los distintos productos de toda la Tierra, en las cantidades que considerara oportunas, y esperar razonablemente su pronta entrega en la puerta de su casa”. Al señalar la fácil disponibilidad del transporte, las comunicaciones y las noticias, observaba que se trataba de una época en la que las clases media y alta disfrutaban de “comodidades, conveniencias y amenidades más allá del alcance de los monarcas más ricos y poderosos de otras épocas”.

Si Keynes hubiera vivido para ver la revolución de la información, habría contemplado el mundo con asombro. El estadounidense medio puede hoy hacer llegar a la puerta de su casa prácticamente cualquier cosa imaginable —un bolígrafo, una granada, un disfraz de Peter Pan— en cuestión de días o incluso de horas. La información y el dinero pueden desplazarse por el planeta en segundos. Basta pulsar un botón o dar una orden verbal a un sirviente digital como Alexa. No es de extrañar que hoy más del 70% de las ventas de libros, más del 40% de las ventas de ropa y el 15% de todas las ventas minoristas en Estados Unidos se realicen en línea. La facilidad de escuchar cualquier canción entre millones en Spotify o de ver en streaming cualquier película jamás producida constituye un avance tan grande que desafía toda comparación. Ningún monarca tuvo nunca ese tipo de entretenimiento al alcance de la mano.

Pese a todas las lamentaciones sobre la era digital, lo cierto es que, para la persona corriente, los beneficios cotidianos superan con mucho a los perjuicios. La gente puede trabajar de manera flexible, liberándose de la tiranía de los horarios fijos y de las oficinas físicas. Los abuelos pueden hacer FaceTime con sus nietos que viven lejos. Cualquiera puede recurrir a un vídeo para aprender una habilidad nueva. Los estudiantes pueden hacer los deberes sin tener que ir a una biblioteca y sacar un libro en préstamo. Podemos trabajar, relacionarnos, jugar, leer y ver contenidos en cualquier lugar y en cualquier momento. No solemos pensar en el placer genuino que nos proporciona la tecnología, pero nuestras acciones revelan hasta qué punto estamos vinculados a ella: la seguimos usando, todos los días de nuestra vida.

Sin embargo, la facilidad y la inmediatez de nuestra existencia en línea también incrementan la angustia y la impaciencia frente a las complejidades de la vida cívica. Ante la compra con un solo clic en Amazon, sistemas desordenados como la democracia liberal, con sus frecuentes bloqueos y su burocracia ineficiente, parecen torpes y anticuados. Pensemos en la promesa de Donald Trump de cortar de raíz el nudo gordiano de la política paralizada. “Solo yo puedo arreglarlo”, declaró. Su estilo comunicativo estaba hecho a la medida de la época. En cuanto tenía una idea, la lanzaba sin más al mundo a través de las redes sociales. Su cuenta de Twitter era un flujo constante de declaraciones impactantes, a menudo descontroladas pero rara vez aburridas. Trump se convirtió primero en una figura pública a través de la prensa sensacionalista y de la telerrealidad, pero fue internet la que lo catapultó a la Casa Blanca. Pudo dirigirse directamente a sus seguidores y dominar un ciclo informativo cada vez más breve. Y sus recetas políticas simplistas —resolver la inmigración ilegal construyendo un muro (y haciendo que México lo pagara), restaurar la industria manufacturera estadounidense imponiendo aranceles (que supuestamente pagarían otros países)— prometían una especie de gratificación instantánea sin coste alguno, algo a lo que la gente se ha acostumbrado en la era de internet.

En la década de 1960, el teórico de los medios Marshall McLuhan —conocido por su célebre máxima “el medio es el mensaje”— predijo que los desafíos planteados por los nuevos medios electrónicos serían casi imposibles de reconocer. Afirmó: “Me encuentro en la posición de Louis Pasteur, diciéndoles a los médicos que su mayor enemigo era completamente invisible y totalmente desconocido para ellos”. Reconocer la validez de la teoría microbiana de Pasteur fue clave para el avance de la medicina. Hoy hemos dado ese primer paso diagnóstico: reconocer los posibles efectos negativos de internet para reconfigurar nuestro cerebro, acortar nuestra capacidad de atención y alimentar las partes más resentidas de nosotros mismos. Pero todavía no hemos avanzado hacia el desarrollo de tratamientos eficaces para lo que nos aqueja; no hay aún nada comparable a una vacuna en el horizonte. Por ahora, pues, obtenemos enormes beneficios de la tecnología de la información, aunque, hay que admitirlo, a un precio elevado.

Jugar a los bolos en solitario

Cuando internet comenzó a popularizarse en la década de 1990, se produjo un resurgir del imaginario utópico: el mundo nunca había estado tan interconectado, las posibilidades de nuevos vínculos sociales nunca habían sido tan amplias. Hoy, una persona joven gay en una comunidad rural de Estados Unidos, sin iguales ni referentes con quienes confiar, puede escapar de una realidad juzgadora y encontrar apoyo y orientación en Facebook e Instagram; una minoría religiosa en una región tribal de Pakistán puede hallar camaradería a través de parientes lejanos en WhatsApp. En efecto, las nuevas redes en línea han supuesto un beneficio inmenso para quienes se encuentran aislados o estigmatizados en su entorno.

Pero al mismo tiempo que la revolución digital ha creado nuevas formas de participación comunitaria, ha acelerado una putrefacción en el seno de la sociedad. La digitalización ha devastado las comunidades locales, y las afiliaciones tradicionales se han debilitado a medida que las generaciones más jóvenes han trasladado sus vidas al ámbito digital. ¿Fue este un pacto fáustico? Hemos obtenido comodidad y eficiencia al precio de perder compromiso cívico, intimidad y autenticidad. En ello vuelve a resonar el eco del poeta Oliver Goldsmith: “La riqueza se acumula, y los hombres se marchitan”. En medio de semejante desarraigo, las personas se sienten atraídas por comunidades marginales en línea —o incluso rechazan la modernidad en sí—, apartándose de la democracia liberal, del crecimiento económico y del progreso tecnológico.

No ocurrió de la noche a la mañana. En su libro de 2000 Bowling Alone, el politólogo Robert Putnam describió el declive de la vida comunitaria compartida en los suburbios estadounidenses desde la década de 1950. Las asociaciones voluntarias habían sido la columna vertebral de la sociedad estadounidense desde la época de Tocqueville. Sin embargo, Putnam constató que los clubes rotarios, los grupos parroquiales y las ligas deportivas de adultos se habían atrofiado. Hoy, la mayoría de los estadounidenses no puede nombrar a una sola “persona influyente local”, lo que indica un deterioro de sus vínculos comunitarios. Las redes sociales han facilitado cada vez más conexiones en línea, pero los estadounidenses se han vuelto crecientemente solitarios. El porcentaje de hombres estadounidenses que afirma tener más de diez amigos íntimos cayó del 40% en 1990 al 15% en 2021. De forma alarmante, el número de quienes dicen no tener ningún amigo cercano aumentó del 3% al 15%. En 2023, el cirujano general de Estados Unidos, Vivek Murthy, publicó un informe sobre la creciente crisis de salud pública de la soledad, documentando que sus efectos nocivos son comparables a fumar quince cigarrillos al día.

El psicólogo Jonathan Haidt ha sostenido de manera convincente que las redes sociales son en parte responsables. En el vacío dejado por la erosión de las comunidades, internet ha fomentado conductas y vínculos poco saludables. Desde 2012, los indicadores de salud mental adolescente —intentos de suicidio, hospitalizaciones por autolesiones, sentimientos de ansiedad y depresión declarados por los propios jóvenes— han empeorado de forma significativa. Coincide aproximadamente con el momento en que los jóvenes pasaron de los teléfonos plegables a los smartphones y con la transformación de las redes sociales en la forma adictiva que hoy reconocemos. En 2009, Facebook introdujo su icónico botón de “me gusta” y Twitter lanzó la función de “retuitear”. Con estos desencadenantes dopaminérgicos de popularidad virtual, la vida en línea pasó, en muchos sentidos, a subsumir las relaciones presenciales. Estos vínculos de asociación digital son débiles y, en ocasiones, incluso malignos.

A finales de 2017, Reddit cerró un grupo de apoyo de cuarenta mil miembros dedicado al “celibato involuntario”, o “incel”, destinado a “personas que carecen de relaciones románticas y sexo”. Lo que comenzó como un foro para gente solitaria se había vuelto rápidamente tóxico: hombres despotricando contra mujeres que no querían acostarse con ellos e incluso defendiendo la violación. El daño generado por estas comunidades también se manifiesta fuera de internet. Elliot Rodger, un joven de veintidós años que se autodefinía como incel, disparó contra tres mujeres en una residencia universitaria cerca de la Universidad de California en Santa Bárbara en 2014. En un vídeo de YouTube subido antes del ataque, había prometido “venganza” por el rechazo femenino.

Por cada uso inocuo de internet —“¡Ornitólogos del Gran Tuscaloosa, uníos!”— existen otros foros que actúan como incubadoras de radicalismo. Muchos adultos, que llevan vidas cada vez más aisladas, han acudido a internet y han encontrado un sentido de propósito compartido en la política crecientemente virulenta de nuestro tiempo. Por perturbadoras y fantasiosas que puedan ser algunas teorías conspirativas —oscuras visiones de camarillas globalistas y redes de abuso sexual infantil ocultas en pizzerías—, estos relatos pueden ofrecer una forma retorcida de consuelo, una narrativa coherente que sustituye al azar. En lugar de átomos impotentes a merced de fuerzas anónimas, estos creyentes se presentan como héroes trágicos de su propia historia, víctimas de enemigos identificables y derrotables. En su versión de los hechos, el vaciamiento de sus pueblos y el declive de las carreras estables no fueron el resultado de transformaciones económicas y tecnológicas acumuladas durante generaciones, sino la consecuencia de decisiones reversibles tomadas por siniestras élites globales.

Esta reacción psicológica no es un fenómeno nuevo. En el siglo XX, la filósofa política Hannah Arendt sostuvo que las ideologías totalitarias solo lograron tanta tracción porque las sociedades estaban profundamente atomizadas. El imperialismo y el capitalismo habían llevado riqueza a las naciones europeas, pero también habían desestabilizado las jerarquías tradicionales y dejado a muchas personas sin afiliaciones sociales. Como resultado, la gente se vio atraída por ideas que ofrecían un sentido claro de identidad y explicaciones simples para un mundo cada vez más complejo. En las páginas finales de Los orígenes del totalitarismo, Arendt escribió: “Lo que prepara a los hombres para la dominación totalitaria en el mundo no totalitario es el hecho de que la soledad, antaño una experiencia límite que solía sufrirse en determinadas condiciones sociales marginales como la vejez, se ha convertido en una experiencia cotidiana de las masas cada vez más numerosas de nuestro siglo”. Por desgracia, la revolución digital no solo ha exacerbado las fuerzas de la soledad y la atomización, sino que también ha empoderado a quienes buscan explotarlas.

En algún lugar, en cualquier lugar

Entonces, ¿qué es cierto? ¿La reluciente fachada de “cada hombre un rey”? ¿O la descomposición social de “jugar a los bolos en solitario”? La respuesta es: ambas cosas, aunque sus efectos se distribuyen de manera profundamente desigual. La economía digital, con todas sus promesas, ha hecho que la desigualdad se dispare hasta niveles no vistos desde la Edad Dorada.

A medida que el mundo cambiaba bajo sus pies, muchos políticos estadounidenses han actuado como si aún viviéramos en el mundo dominado por la industria manufacturera de los años sesenta. Barack Obama en 2012 y Hillary Clinton en 2016 recurrieron a los habituales llamamientos demócratas al sindicalismo organizado. Pero en ambas elecciones, los afiliados a sindicatos votaron en mayor proporción a los republicanos que en 2008. Aunque nunca lo expresarían así, el mensaje implícito de la mayoría de los políticos demócratas a un trabajador despedido y vuelto redundante por la globalización y la tecnología viene a ser algo como esto: “Tu antiguo empleo no va a volver, así que tu mejor esperanza en la economía digital es reciclarte para una carrera completamente distinta en una nueva ciudad o en otro Estado. Tus hijos deberían asegurarse de recibir una educación mejor que la tuya y buscar nuevos centros de crecimiento, lejos de ti”. Esto es una economía eficiente, pero una mala política. Les dice a las personas que, para salir adelante en el nuevo mundo, deben alterar de manera fundamental quiénes son. (Biden ha adoptado un enfoque distinto, con una serie de políticas destinadas a revitalizar la industria manufacturera. Es una economía ineficiente, pero una buena política.)

La revolución digital aceleró el desplazamiento del empleo desde la industria manufacturera y la agricultura hacia el sector servicios. En el proceso, deshizo el entramado de muchas comunidades. En las últimas décadas, los ingresos de la mayoría de las personas de clase trabajadora y del mundo rural no han disminuido de forma drástica, aunque sí se han estancado en comparación con los de sus pares urbanos y con estudios superiores. Pero la reconfiguración de la geografía estadounidense ha socavado las estructuras comunitarias que sostenían la vida social y cultural de la América de las pequeñas ciudades. ¿La tienda familiar de barrio? Desaparecida, incapaz de competir con Amazon. ¿El salón recreativo de la esquina? Desplazado por los videojuegos en línea. ¿El cine local? Expulsado por Netflix. Todos estos son ejemplos de lo que el capitalista de riesgo Marc Andreessen quiso decir cuando afirmó: “El software se está comiendo el mundo”. Los negocios físicos comprueban que la tecnología digital tiene un impacto muy real en el mundo material.

Una pequeña ciudad, con sus negocios familiares, es para sus habitantes un lugar único, un “algún lugar”, en palabras del escritor británico David Goodhart. Moldea la vida de muchos de sus vecinos, que se definen de un modo que habría resultado familiar siglos atrás: como personas de ese lugar, ya sea Alabama, Shropshire o Toulouse. Pero cada vez más, hombres y mujeres jóvenes de estos sitios se marchan para formarse y encontrar trabajo de cuello blanco, se agrupan con sus iguales en regiones metropolitanas conectadas globalmente y pasan a formar parte de una clase desarraigada de “cualquiera”. Los “cualquiera”, escribe Goodhart, no se definen por su lugar de nacimiento, sino por su educación o su profesión. Son esas características adquiridas las que dan forma a sus vidas. A medida que los jóvenes “de algún lugar” se convierten en “de cualquier lugar”, esto vacía aún más las ciudades que dejan atrás y amplifica una concentración de talento de tipo ganador-se-lo-lleva-todo. Los beneficiarios de la economía globalizada de alta tecnología extraen su identidad de aspectos de su vida que son maleables —educación, profesión, pasiones—. Pero no todo el mundo quiere ser un “cualquiera” flotante. Muchas personas obtienen su sentido de identidad y de satisfacción vital de sus raíces, de estar ancladas en una geografía concreta: de ser “de algún lugar”.

Una nueva generación de republicanos populistas ha recogido la idea de los “cualquiera” como desleales, incluso “antiamericanos”. Estos republicanos resienten a los urbanitas autosatisfechos que desprecian sus pueblos natales mudándose a la Costa Este o a la Costa Oeste. Cuando Josh Hawley lanzó su campaña al Senado por Misuri contra Claire McCaskill en 2018, arremetió contra las “élites costeras” que miran con desdén al corazón del país como simple “territorio de sobrevuelo”. En la campaña al Senado por Ohio en 2022, el autor de Hillbilly Elegy, J. D. Vance, denunció el “mensaje tóxico” dirigido a chicos y chicas jóvenes según el cual deberían marcharse de sus lugares de origen. Poco importa que muchos de estos supuestos campeones de las pequeñas ciudades buscaran ellos mismos oportunidades mudándose a grandes universidades o a grandes urbes (Hawley y Vance tienen ambos títulos de Derecho por Yale). La verdad es que el impulso de ascender es fuerte, y a menudo eso significa alejarse de “algún lugar”.

Cómo vive la otra mitad, 2.0

Los ingresos de los hogares han crecido con solidez desde la revolución digital. Pero los promedios ocultan enormes concentraciones de riqueza y también un intenso sufrimiento económico. Y para muchos, las cifras no alcanzan a transmitir la inestabilidad provocada por un cambio tan rápido. Se lamenta la disolución de los vínculos comunitarios y el cierre de pequeños negocios. Amplias franjas del país se enfrentan hoy a la desolación económica, en un mundo muy alejado de las relucientes (y prohibitivamente caras) ciudades superestrella.

Estas disparidades se exhiben de manera constante en las redes sociales. A medida que cada vez más personas comparten su vida privada en línea, crece una hiperconciencia de los estilos de vida de la élite global. Podríamos llamarlo “Cómo vive la otra mitad, 2.0”. El reportaje original de Jacob Riis, publicado en 1890, utilizó la entonces novedosa tecnología de la fotografía para mostrar, con un detalle descarnado, las míseras condiciones de vida de los inquilinos de los edificios de vecindad de Manhattan. Confrontadas con esas imágenes, las élites sintieron la responsabilidad de ayudar a las masas. Implantaron regulaciones para reducir el hacinamiento y garantizar una salubridad adecuada.

Hoy, los teléfonos inteligentes y las redes sociales han creado una conciencia similar de la desigualdad, pero en sentido inverso. En lugar de élites culpables que toman conciencia de la miseria de las masas, ahora son las personas corrientes las que se han vuelto dolorosamente conscientes de los estilos de vida de los ricos y famosos. Desde remolques y apartamentos diminutos en Estados Unidos —o desde aldeas remotas del Sur Global—, cualquiera con un teléfono de 100 dólares puede contemplar con envidia, anhelo y resentimiento cómo las élites gastan su dinero. Escapadas a villas italianas, fiestas exclusivas en azoteas y jardines zen impecablemente compuestos desfilan ante la pantalla con un simple gesto del pulgar.

Esta dinámica es, de hecho, especialmente relevante en el mundo en desarrollo, donde las brechas de estilo de vida entre las élites y la población media son más acusadas. El resentimiento resultante puede haber contribuido a desencadenar y sostener levantamientos como la Primavera Árabe. En noviembre de 2010, por ejemplo, WikiLeaks comenzó a publicar cables diplomáticos de la embajada estadounidense en Túnez que exponían la corrupción del entonces presidente tunecino Zine el-Abidine Ben Ali. La Primavera Árabe estalló en Túnez un mes después. De forma similar, ya en 2009 algunos medios informaban de cómo la esposa del dictador sirio Bashar al-Ásad “alardeaba de su vestuario de diseñador en Facebook”, mientras su país padecía pobreza y represión. (Un periódico británico la calificó como “la Primera Dama del Infierno”, una expresión que las redes sociales adoptaron rápidamente.) Este sentimiento alimentó el descontento público en Siria y desembocó en la guerra civil siria en 2011.

Nuestra fascinación por los estilos de vida glamurosos siempre ha existido —durante la Edad Dorada, los periódicos escribían sobre bailes fastuosos y mansiones opulentas—, pero hoy la vida de muchas celebridades se exhibe por completo. Comparar la propia vida ordinaria con la de los ricos es más fácil que nunca, lo que genera una comprensible envidia y resentimiento. Quizá resulte aún más irritante que incluso las élites corrientes —no celebridades, sino ingenieros de software o profesionales de las finanzas— hayan avanzado a gran velocidad. McAfee y Brynjolfsson explican bien el problema: “Nunca ha habido un momento mejor para ser un trabajador con habilidades especiales o la formación adecuada, porque estas personas pueden utilizar la tecnología para crear y capturar valor. Sin embargo, nunca ha habido un momento peor para ser un trabajador que solo puede ofrecer habilidades y capacidades ‘ordinarias’, porque los ordenadores, los robots y otras tecnologías digitales están adquiriendo esas habilidades y capacidades a un ritmo extraordinario”. La desigualdad de ingresos en Estados Unidos ha aumentado de forma sostenida desde el inicio de la revolución digital. En los últimos cincuenta años, los ingresos de los hogares han crecido tres veces más rápido para el 20 % con mayores ingresos que para el quintil medio.

Esta desigualdad ha contribuido a alimentar el populismo tanto en la derecha como en la izquierda: no solo la ira contra los multimillonarios y las grandes corporaciones, sino también contra toda una clase de élites globales percibidas como corruptas y movidas por el interés propio.

La nueva imprenta

Aunque la riqueza se ha distribuido de manera cada vez más desigual, una de las grandes fuentes de poder y riqueza a lo largo de la historia se ha democratizado: la información. Estás a un solo clic de saber prácticamente cualquier cosa. No solo se ha democratizado el consumo de información, sino también su producción. Las redes sociales y la descentralización de las fuentes mediáticas han llevado nuevas voces al primer plano, permitiendo que cualquiera, independientemente de su formación o estatus, participe en la conversación global.

No es la primera vez que la tecnología aplana la producción y el consumo de contenidos. Como ha señalado la historiadora Ada Palmer a propósito de Gutenberg, “muchos momentos de la revolución que la imprenta desató fueron tan aterradores como beneficiosos”. Pero añade que las numerosas nuevas formas de medios que han aparecido desde el siglo XV “nos muestran que democratizar la expresión siempre favorece la democratización del poder, facilita la organización comunitaria, los movimientos por los derechos civiles, la justicia, la dignidad humana y el florecimiento humano”; al menos —cabría añadir— en términos generales y a largo plazo. A corto plazo, sin embargo, las transformaciones pueden generar un gran caos. Basta recordar lo que siguió a la invención de la imprenta en Europa: un siglo y medio de guerras religiosas.

La democratización de la información en internet ya ha transformado la política. Twitter ayudó a facilitar las protestas durante la “Revolución Verde” de Irán en 2009, un temprano temblor en Oriente Próximo que presagiaba el verdadero terremoto: la Primavera Árabe de 2011. Al permitir a las personas eludir los canales tradicionales de los medios y los controles opresivos del gobierno, internet proporcionó un nivel de transparencia sin precedentes, posibilitó la rápida difusión de la disidencia y movilizó a personas a través de las fronteras hacia la acción colectiva. Millones de personas en todo el mundo árabe se manifestaron contra la corrupción, la mala gestión económica y los abusos dictatoriales: la mayor oleada multinacional de levantamientos democráticos desde el año revolucionario europeo de 1848.

Sin embargo, la relación de apoyo mutuo entre la política democrática y la tecnología de la información resultó frágil, y pronto aparecieron fisuras. Las redes sociales pueden ser útiles para generar energía y atención con rapidez, pero cuando se trata de construir movimientos sostenidos, su naturaleza fragmentada y sin liderazgo dificulta los cambios políticos reales a largo plazo. Todos y cada uno de los movimientos democráticos surgidos de la Primavera Árabe han sido desde entonces reprimidos. En Estados Unidos, el estallido de izquierda de Occupy Wall Street se desinfló sin lograr grandes victorias políticas en Washington. Un defecto igualmente importante de los movimientos asistidos por internet es que, aunque son democráticos en cierto sentido, su carácter anónimo y de multitud puede hacerlos también susceptibles a tendencias iliberales. En Francia, las protestas de los Chalecos Amarillos contra una propuesta de subida del impuesto sobre los combustibles se articularon con rapidez en 2018, pero pronto degeneraron en estallidos dispersos y sin liderazgo, muchos de los cuales se volvieron violentos o xenófobos.

Los Estados autoritarios han reaccionado con hostilidad ante la capacidad de internet para alimentar movimientos de base y han intentado sofocarlos mediante aparatos agresivos de censura. El ejemplo más destacado es el Gran Cortafuegos de China, un régimen de censura de internet bastante exhaustivo que mantiene a raya la mayor parte de la disidencia. China no solo bloquea automáticamente contenidos subversivos —las búsquedas de “independencia de Hong Kong”, “Dalai Lama” y “masacre de Tiananmén” no arrojan resultados—, sino que además recluta a internautas ultranacionalistas en una turba digital conocida como el “Ejército de los 50 céntimos”, llamado así por los pequeños pagos que reciben por cada comentario en el que denuncian los valores occidentales y elogian a Xi Jinping. En las plataformas chinas de redes sociales, las publicaciones públicas que adoptan una postura contraria al régimen se ven con frecuencia inundadas por una avalancha de comentarios que expresan un apoyo inquebrantable al Partido Comunista y condenan a quienes discrepan como traidores.

En el año 2000, el presidente Bill Clinton desestimó los intentos de China por censurar internet como algo condenado al fracaso. “¡Buena suerte!”, dijo. “Eso es como intentar clavar gelatina en la pared”. El Gran Cortafuegos chino ha puesto a prueba la arrogancia de Clinton, demostrando ser más eficaz de lo que muchos creían posible. Y, sin embargo, incluso bajo estas condiciones extremadamente represivas, ni el Gran Cortafuegos ni los lacayos digitales del Partido pueden impedir que la disidencia aflore. Basta pensar en las protestas contra los confinamientos que surgieron en las principales ciudades chinas en el otoño de 2022. Y fuera de China, a regímenes autoritarios como el de Vietnam les ha resultado más difícil censurar las redes sociales. Los gobiernos —también los democráticos— se han vuelto más hábiles en la censura. India y Turquía cortan de forma rutinaria el acceso a internet durante las crisis para impedir la propagación de la disidencia. Rusia, desde que lanzó su invasión a gran escala de Ucrania, ha intentado replicar el Estado de vigilancia digital chino, con un éxito limitado. Las redes sociales son una fuerza poderosa para la libre expresión, pero los gobiernos también han encontrado nuevas formas de domesticarlas.

Hoy resulta difícil sentirse optimista respecto a la promesa democrática de las redes sociales. Las nuevas tecnologías de la información han tendido a empoderar a voces marginadas, pero también a las más extremas. Y ha sido complicado traducir la disidencia en poder real. Dar “me gusta” a algo en Facebook no es más que señalización virtuosa de alta tecnología. Y ha surgido otra tendencia inquietante en las democracias occidentales: en nombre de dar voz a quienes no la tienen, muchos acaban siendo silenciados.

Tribalismo antiguo, redes nuevas

En 2021, el comentarista Noah Smith observó: “El ostracismo social es tan antiguo como el mundo. Las redes sociales no”. En otras palabras, ser estigmatizado por creencias impopulares no es nada nuevo. Basta pensar en Sócrates, desacreditado y finalmente ejecutado por sus ideas subversivas. El término “ostracismo” procede en realidad de la Atenas antigua, que contaba con un proceso formal de votación para desterrar a personas de la ciudad. A lo largo del resto de la historia, disidentes e iconoclastas han sido purgados y castigados por herejía, por pensamiento incorrecto u otras formas de inconformismo. Durante la mayor parte de la existencia humana en la Tierra, ha sido la norma imponer con dureza los límites de lo que se considera creíble o aceptable. Quienes estiran o traspasan esos límites —los Galileo y los Gandhi— se enfrentan a consecuencias severas.

Los castigos hoy pueden ser mucho menos severos, pero la tecnología ha alterado radicalmente el alcance y el contexto de la expresión impopular. Pensemos en una asamblea municipal, una democracia directa al estilo tradicional de Nueva Inglaterra, en algún momento de la década de 1940: por ejemplo, el hombre que se levanta y toma la palabra en el icónico cuadro de Norman Rockwell Freedom of Speech. El orador compartía sin duda una enorme cantidad de bagaje social y cultural con su audiencia. Todos los presentes eran blancos y del mismo pueblo. Probablemente habían crecido juntos y eran abrumadoramente cristianos, muchos de ellos asistentes a la misma iglesia. Incluso si discrepaban de él, el orador podía escuchar y responder: si el público empezaba a moverse inquieto y a murmurar en sus asientos, podía percibir que su mensaje no estaba siendo bien recibido.

En las cámaras de eco en línea de hoy, como Twitter, no existe esa comunidad de referencias. Que se le diga a alguien que “lea la sala” al tratar temas controvertidos supone que los interlocutores —separados como estén por la distancia, las fronteras o las culturas— forman parte de un espacio comunitario en línea con normas compartidas. No es de extrañar que los intentos de los primeros soñadores de internet por construir una cultura digital universal se hayan topado con tantos obstáculos.

Marshall McLuhan acuñó el término “aldea global” en la década de 1960 para describir la creciente interconexión del mundo. En los años noventa, con la Guerra Fría terminada y la globalización a toda máquina, esta expresión evocaba un mundo arcoíris, manos unidas en un círculo de Kumbaya, con internet tejiendo el planeta en un todo sin fisuras. Pero McLuhan no era tan optimista. Temía una comunidad tecnológicamente conectada en la que perfectos desconocidos se comportaran como cotillas de pueblo: husmeando en los asuntos ajenos, mirando por las ventanas de los demás y haciendo cumplir un repertorio cada vez más estrecho de conductas sociales aceptables. ¿No es ese el mundo en línea de hoy? En ciertos círculos digitales de izquierda, escribir historias desde una perspectiva ajena a tu grupo identitario puede acarrear denuncias por apropiarse de las “experiencias vividas” de otros. En el otro extremo, publicar una foto con mascarilla durante la pandemia podía bastar para que te vetaran amplios sectores de la internet conservadora. Es la tiranía de una minoría apasionada: pequeños grupos de fanáticos en línea que buscan controlar el discurso.

La revolución de la información ha empoderado a los miembros más irresponsables e incendiarios de nuestras sociedades, y sus opiniones suelen ser disparatadas y, a veces, peligrosas. En la izquierda hay quienes abogan por fronteras abiertas, justifican el ecoterrorismo e incluso exigen la abolición de la policía. Pero la derecha parece más susceptible a las teorías conspirativas en línea: basta pensar en los seguidores de QAnon, los antivacunas, los negacionistas del clima o los supremacistas blancos. Es cierto que los movimientos marginales siempre han existido —en el siglo XVI, algunos fanáticos protestantes estaban tan convencidos de la inminencia del fin de los tiempos que se apoderaron de una ciudad alemana y masacraron a cualquiera que se opusiera—. La gente ha creído toda clase de teorías conspirativas sobre brujas, judíos, masones, ovnis, JFK o los Beatles. Pero internet concentra a los conspiracionistas y, con ello, amplifica de manera masiva su poder. Alex Jones creó un negocio multimillonario basado en delirios sobre tiroteos fingidos, conspiraciones satánicas globalistas y ranas homosexuales, y llegó a tener a Donald Trump cortejándolo.

Con la ayuda de Rusia y de otros actores poco escrupulosos, estos canales en línea han acelerado la difusión de la desinformación, erosionando de forma generalizada la confianza pública en el proceso democrático. Las encuestas muestran de manera sistemática que alrededor de dos tercios de los republicanos creen que las elecciones presidenciales de 2020 fueron fraudulentas e ilegítimas. El escepticismo electoral se difundió en parte por medios tradicionales, desde luego, pero las redes sociales contribuyeron de forma decisiva a incrustar la “gran mentira” en la opinión pública estadounidense.

El problema de la desinformación no hará sino agravarse con los avances en inteligencia artificial. Los usos más benignos de la IA generativa permiten crear, en cuestión de segundos, obras de arte que nunca se han pintado (por ejemplo, un retrato de Rembrandt de Dwayne “The Rock” Johnson) o música que nunca se ha cantado (una versión de Frank Sinatra de una canción de Taylor Swift). Pero esta tecnología puede emplearse con facilidad para fines mucho más malignos. Los llamados deepfakes ya han aparecido durante la guerra en Ucrania: uno de los vídeos, por ejemplo, pretendía mostrar a Putin anunciando que las fuerzas ucranianas habían invadido Rusia. El vídeo fue rápidamente desmentido, pero a medida que los deepfakes aumenten en calidad y frecuencia, el problema no hará sino empeorar.

La incapacidad para dirimir entre verdad y falsedad ya ha irrumpido en la mayor democracia del mundo, la India. En el estado meridional de Tamil Nadu, donde el Bharatiya Janata Party —dominante a nivel nacional— ha tenido dificultades para abrirse paso, se difundió un archivo de audio en el que un político rival hablaba de la corrupción de su propio partido. El acusado desestimó la grabación como un deepfake, pero los analistas expertos no pudieron determinar de forma concluyente si el audio era auténtico. Resulta fácil imaginar cómo los deepfakes podrían desestabilizar de manera similar la política estadounidense. En la víspera de unas elecciones presidenciales, aparece en internet un vídeo que supuestamente muestra a uno de los candidatos aceptando un soborno de un funcionario del Partido Comunista chino. Los medios generalistas y los verificadores de hechos lo califican de falso, pero la mitad del país, alentada por su líder político, llega a creer que el incidente es real.

Debemos estar alerta ante disrupciones tan peligrosas, pero sin perder la cabeza ni actuar como si la tecnología fuera la única culpable. Por desgracia, la naturaleza humana ha demostrado ser extraordinariamente susceptible a la paranoia, la conspiración y el delirio mediante métodos mucho más rudimentarios. Basta pensar en Los protocolos de los sabios de Sion. Este tosco panfleto antisemita apareció en 1903 y circuló durante décadas, alimentó pogromos en toda Europa y pasó a formar parte de la ideología rectora del nazismo. O recordemos la masacre de Jonestown en 1978, que causó la muerte de casi mil personas. El envenenamiento masivo se organizó fuera de línea, mediante formas tradicionales de proselitismo sectario. Las redes sociales y la inteligencia artificial pueden acelerar la propagación del odio y la locura. Pero las ideas terribles pueden volverse virales por cualquier medio, ya sea de alta o de baja tecnología.

Los robots no te están quitando el trabajo (todavía)

Para la mayoría de las personas, la mayor amenaza procedente de la tecnología no es la proliferación de grupos de odio en línea ni ser “canceladas” o censuradas. Es, más bien, el temor a perder su empleo a causa de la automatización. Y no son solo los trabajadores manuales quienes se inquietan ante este proceso: cuando actores y guionistas de Hollywood se declararon en huelga en 2023, una de sus principales reivindicaciones se refería a la posibilidad de que los estudios recurrieran a actores o diálogos generados por inteligencia artificial.

No hay duda de que algunas ocupaciones ya se han visto afectadas por la era de las máquinas. Pensemos en los cajeros, cuyo número se ha reducido con la expansión del autoservicio en los supermercados. Pero, salvo en algunas tiendas experimentales de Amazon, los cajeros distan mucho de haber desaparecido por completo. Siempre habrá clientes que prefieran el trato humano, y los comercios siempre necesitarán personas que supervisen las máquinas. En 2018, la Cámara de los Comunes británica publicó un informe sobre automatización y empleo en otro lugar de trabajo aparentemente trivial: el humilde lavadero de coches. ¿Otro lamento por los empleos perdidos a manos de los robots y la mengua de oportunidades para la clase trabajadora? No. De hecho, el informe no trataba de automatización, sino de des-automatización. Entre 2006 y 2016, el Reino Unido perdió más de 1.100 lavaderos automáticos, mientras surgían entre 10.000 y 20.000 lavaderos manuales. Los consumidores preferían estos últimos porque resultaban, en realidad, más baratos y más convenientes, pese a estar operados por personas. (El informe se centraba en la preocupación de que los lavaderos manuales incumplieran la legislación laboral y medioambiental).

Los lavaderos de coches no son una fuente de empleo particularmente relevante, pero el argumento de fondo es que los seres humanos están todavía muy lejos de ser sustituidos por robots. Incluso tras el impacto de la pandemia de la COVID-19, el efecto no fue expulsar del mercado laboral a grandes contingentes de trabajadores manuales poco cualificados. Al contrario, cuando la sociedad volvió a abrirse, la economía sufrió una escasez de mano de obra en un contexto de demanda de trabajadores sin precedentes en la historia moderna. Los empleadores compitieron ferozmente por atraer empleados, incluso para puestos de entrada y no cualificados. Algunos restaurantes llegaron a ofrecer primas de contratación; otros estaban tan faltos de personal que a los empleados ebrios se les enviaba simplemente a casa en lugar de despedirlos. El futuro tan temido —el de las máquinas arrebatando millones de empleos y provocando “el fin del trabajo”— sencillamente no se ha materializado, al menos por ahora.

Es cierto que algunos empleos han desaparecido, pero muchos otros se han creado. Y para algunos trabajadores, la tecnología no los ha sustituido, sino que los ha reforzado mediante una suerte de prótesis física o mental. Además, todavía estamos en las primeras fases de estos robots colaborativos —los llamados “cobots” en la jerga industrial—. Pensemos en las posibilidades: una agricultora consulta una tableta con imágenes satelitales de sus campos, complementadas con grabaciones de drones, y controla varias cosechadoras desde una sola plataforma; un médico es orientado hacia una intervención quirúrgica distinta por una herramienta de aprendizaje automático que ha analizado millones de casos previos en busca de patrones; un encargado de fábrica supervisa una cadena de montaje compuesta en parte por robots y en parte por técnicos, programadores e ingenieros que dirigen, reparan y apoyan a las máquinas. Ya hoy, estos sectores se han beneficiado de la digitalización, que ha agilizado los procesos y mejorado la formación de los trabajadores. El software también ha dado lugar a campos enteramente nuevos —desde los videojuegos hasta las redes sociales o el desarrollo de aplicaciones—, creando tipos de empleo distintos y novedosos.

Pero las inquietudes persisten y, a largo plazo, el desempleo inducido por la inteligencia artificial podría materializarse. Andreessen dijo en 2011 que el software estaba “devorando el mundo”, pero con la llegada de ChatGPT, los capitalistas de riesgo Paul Kedrosky y Eric Norlin sostienen que el software puede “terminar de devorarlo”. ChatGPT es, en sí mismo, software: barato, potente y con capacidad para trastocar numerosos sectores. Puede responder a todo tipo de preguntas y redactar desde materiales de marketing hasta artículos periodísticos o documentos legales. También puede potenciar el software ya existente. Por ejemplo, Salesforce ha integrado esta tecnología en sus herramientas de modo que, cuando a un comercial se le asigna una nueva cuenta, ChatGPT puede ofrecer un resumen de la empresa, localizar la información de contacto de las personas adecuadas y redactar un correo electrónico personalizado —y, si es necesario, hacerlo menos formal—. Instacart lanzó una función basada en ChatGPT que sugiere una receta, la convierte en una lista de la compra y añade los productos al carrito en línea. El software de chatbots puede incluso utilizarse para crear otro software. Al fin y al cabo, los chatbots generan texto, y el código informático es una forma de escritura. Así, ahora alguien puede crear su propio software simplemente introduciendo instrucciones en ChatGPT. Andrej Karpathy, cofundador de OpenAI (la empresa detrás de ChatGPT), proclamó: “El nuevo lenguaje de programación más popular es el inglés”. Todo ello apunta a una proliferación aún mayor de software, lo que implica que muchos más empleos podrían verse alterados o automatizados.

No se trata solo de trabajos de cuello blanco en marketing, derecho o programación. Pensemos en una IA conectada a robots. Muchos empleos manuales han resultado demasiado complejos para ser automatizados, pero un robot “pensante” podría ser capaz de desempeñarlos. El ejemplo más esperado es probablemente el de los vehículos autónomos, que no solo transformarían el transporte personal, sino que volverían obsoletos a camioneros, conductores de autobús y chóferes de Uber. La tecnología sigue en una fase incipiente, pero algún día podría eliminar los empleos de conducción que hoy ocupan casi cuatro millones de estadounidenses —en su mayoría hombres y, en su mayoría, sin estudios universitarios—. El presentador conservador Tucker Carlson ha opinado que prohibiría los camiones sin conductor para proteger estos empleos manuales.

Este tipo de neoludismo no es exclusivo de la derecha. En 2017, Bill Gates propuso un “impuesto a los robots”, que obligaría a las empresas a pagar al fisco cuando sustituyan a un trabajador humano por una máquina (una idea que, entre otros problemas, resulta bastante impracticable). En 2022, la administración Biden destinó 684 millones de dólares a modernizar los puertos de todo el país, tras los atascos en el transporte marítimo que habían entorpecido las cadenas de suministro globales, pero con la condición de que no se instalara ninguna tecnología que provocara una pérdida neta de empleos. Este planteamiento es literalmente contraproducente: elige la ineficiencia frente a la productividad. Recuerda a una anécdota que el economista Milton Friedman contaba sobre una visita que realizó a un país asiático en los años sesenta. Recorrió una obra donde se estaba construyendo un canal y le sorprendió ver a los trabajadores usando palas en lugar de tractores y excavadoras mecanizadas. Preguntó a un funcionario del Gobierno, que le respondió: “No lo entiende. Esto es un programa de empleo”. Friedman replicó: “Ah, creía que estaban intentando construir un canal. Si lo que quieren son empleos, entonces deberían darles cucharas, no palas”.

Los temores en torno a la automatización son comprensibles, y nunca lo han sido tanto como ahora que la inteligencia artificial ha logrado avances espectaculares. Pero, a lo largo de la historia, la tecnología, a largo plazo, ha creado más empleos y ha mejorado nuestras vidas. Negarse a utilizarla sería insensato. Si finalmente llegara a provocar “el fin del trabajo”, entonces tendríamos que replantearnos la sociedad de manera radical. En 1930, John Maynard Keynes predijo que la productividad aumentaría tanto que sus nietos solo tendrían que trabajar quince horas a la semana. Suena al tipo de utopía que Marx imaginaba, en la que una persona podría “pescar por la mañana, cazar por la tarde, criar ganado al anochecer y criticar después de cenar… sin llegar a convertirse nunca en pescador, cazador, pastor o crítico”.

No dejemos, sin embargo, que la imaginación o el miedo nos arrastren demasiado lejos. A largo plazo, la tecnología nunca ha provocado desempleo masivo y, hasta ahora, tanto Keynes como Marx han estado muy equivocados en este punto. Por supuesto, a los políticos puede resultarles difícil resistirse a los votantes que exigen que el Estado proteja sus empleos. Pero los dirigentes no deberían obstaculizar el progreso tecnológico. Deberían tratar de fomentar la creación de nuevos empleos e industrias, en lugar de insistir en que los trabajadores caven con cucharas en vez de palas.

A medida que la inteligencia artificial se desarrolle, no obstante, transformará nuestra comprensión básica de la capacidad humana. Eric Schmidt, Daniel Huttenlocher y Henry Kissinger señalan en The Age of AI que, desde la Ilustración, los seres humanos han concebido la mente humana como la clave para desentrañar los misterios del universo. La racionalidad humana explicaba fenómenos que en épocas anteriores se atribuían a fuerzas divinas. El Sol salía cada mañana, por ejemplo, porque el dios Sol recorría el cielo en su carro. Pero la IA es tan compleja, sus conjuntos de datos tan vastos y sus cálculos tan numerosos que ningún ser humano puede siquiera comprender cómo llega a sus conclusiones. A medida que mejoren sus capacidades, tendremos que confiar en que la máquina sabe más, depositando nuestra fe en la inteligencia artificial del mismo modo que los seres humanos preilustrados depositaban su fe en Dios. Ken Goldberg, de la UCLA, sostiene de manera similar que, cuando la Revolución Copernicana sacó a la Tierra del centro del universo, en realidad situó a la razón y a la inteligencia humanas en el centro. Una nueva revolución se vislumbra en el horizonte: aquella en la que la inteligencia artificial supere a la humana y nos obligue a replantearnos nuestro propio lugar.

La biología se vuelve inteligente

Junto con la inteligencia artificial, estamos presenciando otro aspecto de la Cuarta Revolución Industrial que podría resultar igual de transformador: la revolución de la bioingeniería. En muchos sentidos, ambas están estrechamente entrelazadas. Basta pensar en el “problema del plegamiento de proteínas”: predecir la estructura tridimensional de las secuencias de aminoácidos que componen las proteínas que los organismos necesitan para funcionar. Desde la década de 1960, este se consideraba uno de los desafíos más difíciles de la biología. En 2020, investigadores equipados con una herramienta de IA llamada AlphaFold resolvieron en esencia el problema del plegamiento de proteínas, abriendo la puerta a un número incalculable de avances en biotecnología.

De manera más amplia, la revolución biotecnológica puede entenderse como otra faceta de la revolución de la información, una que no trata de bits y bytes, sino de los nucleótidos del ADN y el ARN que codifican las estructuras de los seres vivos. Durante más de 3.000 millones de años, la evolución estuvo guiada únicamente por las fuerzas de la selección natural, que permitían la supervivencia de algunas mutaciones y la desaparición de otras. Hoy, sin embargo, los seres humanos están tomando el control de la naturaleza. El auge de la biotecnología moderna permite a los científicos intervenir directamente en el ADN dentro de células vivas, diseñando organismos e incluso diseñando seres humanos. Como han escrito Jennifer Doudna, pionera de la revolucionaria tecnología de edición genética CRISPR, y el bioquímico Samuel Sternberg, “por primera vez en la historia, poseemos la capacidad de editar no solo el ADN de todos los seres humanos vivos, sino también el ADN de las generaciones futuras; en esencia, de dirigir la evolución de nuestra propia especie”.

En 2000, cuando el Proyecto Genoma Humano completó el primer borrador de la totalidad del código genético contenido en el ADN humano, el presidente Bill Clinton anunció: “Hoy estamos aprendiendo el lenguaje en el que Dios creó la vida”. En las dos décadas siguientes, el coste de secuenciar un genoma humano cayó de 100 millones de dólares a menos de 1.000. Un proceso que antes llevaba años ahora se completa en días. Al mediodía del viernes 3 de enero de 2020, un equipo de investigación chino recibió un tubo de ensayo con el ADN del nuevo coronavirus. A las dos de la madrugada del domingo ya habían cartografiado el genoma del virus.

A miles de kilómetros de distancia, dos pequeñas y poco conocidas empresas biotecnológicas estaban a punto de vivir su momento decisivo. La empresa Moderna, con sede en Massachusetts, había afrontado un creciente escepticismo por parte de los inversores ante su ambicioso plan de crear vacunas basadas en ARN mensajero, o ARNm. En 2019, la compañía alemana BioNTech, centrada también en el ARNm, había logrado recaudar apenas algo más de la mitad del capital que esperaba. De repente, la pandemia de coronavirus permitió a ambas demostrar la validez de su enfoque. El ADN es un enorme archivo maestro que permanece fijo en el núcleo de la célula; el ARNm, en cambio, toma pequeñas “instantáneas” del ADN para transmitir las instrucciones necesarias para fabricar proteínas. Los científicos descubrieron rápidamente que este virus concreto tenía ciertas proteínas en forma de espícula en su superficie que, si se alteraban, impedían su capacidad de multiplicarse. Con el genoma del virus en la mano, las empresas podían crear una especie de “retrato policial” de esa proteína espicular y, mediante ARNm, reproducirlo por todo el cuerpo. Cuando el virus real aparecía con su proteína espicular, el sistema inmunitario ya la reconocía y estaba preparado para combatirlo. Al menos, esa era la teoría.

El resultado fue un éxito rotundo, que salvó decenas de millones de vidas. Y la velocidad a la que se desarrolló la vacuna fue sobrecogedora. En abril de 2020, The New York Times estimó que, al ritmo habitual de desarrollo de nuevas vacunas, las inyecciones comenzarían a administrarse a finales de 2033. Alcanzar el objetivo de disponer de una vacuna contra la Covid a mediados de 2021, afirmaba el Times, sería “lograr lo imposible”. Sin embargo, las vacunas de Moderna y Pfizer-BioNTech empezaron a administrarse antes de que terminara 2020.

Pero lo que la ciencia da, la política lo quita. Aunque con el tiempo la mayoría de los estadounidenses acabaría vacunándose, una minoría ruidosa y airada se negó a hacerlo. Denunciaron los mandatos de vacunación como una forma tiránica de extralimitación del poder del Estado. Hubo antivacunas destacados en ambos lados del espectro político, pero fueron los conservadores, en particular, quienes utilizaron el asunto para agitar a la base republicana. J. D. Vance, por ejemplo, calificó los mandatos de vacunación de Biden de “autoritarismo en estado puro”. Ninguna cantidad de explicaciones o exhortaciones por parte de los expertos logró convencer a algunas personas, que rechazaban la vacuna y otros fármacos de vanguardia, pero aceptaban sin reparos la hidroxicloroquina o la ivermectina, que charlatanes presentaban como curas milagrosas. Este tipo de desinformación se difundió por todo el mundo, al igual que teorías conspirativas abiertas, como la creencia de que Bill Gates, que había contribuido a financiar la vacuna, la utilizaba para implantar microchips en la población.

La resistencia a la vacuna refleja niveles peligrosos de polarización, pero también una desconfianza más amplia hacia las élites. Los expertos fallaron al público en la guerra de Irak, en la crisis financiera e incluso en las primeras fases de la pandemia, cuando recomendaron no usar mascarillas. Pero la tecnología ha agravado esa desconfianza. Tom Nichols, autor de The Death of Expertise, sostiene que el mundo se ha vuelto tan complejo que la persona media no entiende cómo funcionan las cosas, se siente impotente y acaba resentida con los expertos. Y, con una cantidad infinita de información a solo un clic de distancia, la gente cree que puede descubrir la verdad por sí misma y prescindir de los especialistas. Poco importa que, en realidad, haga falta un auténtico experto para “abrirse paso entre una ventisca de basura inútil o engañosa” que prolifera en internet. Así, cuando llegó el momento de las vacunas, aunque la mayoría celebró este prodigio de la inventiva humana, una parte significativa de la población rechazó el consejo de los expertos. Les incomodaba una vacuna producida con tanta rapidez y mediante una técnica tan novedosa.

Un escepticismo similar puede observarse en las actitudes hacia los organismos genéticamente modificados, o transgénicos. Con las tecnologías y métodos agrícolas actuales, satisfacer las necesidades alimentarias previstas para 2050 exigiría disponer de una superficie cultivable equivalente a África y Sudamérica juntas. Los transgénicos pueden ayudar a los agricultores a producir más alimentos con menos recursos, permitir que los cultivos resistan un clima cambiante e incluso hacerlos más nutritivos. En la década de 1950, el virus de la mancha anular de la papaya estuvo a punto de acabar con toda la producción de esta fruta en la isla hawaiana de Oahu. Un científico de la Universidad de Cornell, que había crecido en la región, salvó el sector creando una papaya modificada genéticamente inmune al virus. La innovación fue adoptada de forma generalizada por los productores. Hoy, el 80% de la papaya hawaiana está modificada genéticamente.

Hay un final menos feliz en la historia del arroz, un cultivo básico que constituye la única fuente de alimento para muchas personas pobres en países asiáticos. Cada año, la deficiencia de vitamina A mata a un millón de personas en todo el mundo, en su mayoría niños, y deja ciegas hasta a medio millón. Cuando en el año 2000 los científicos desarrollaron una nueva variedad de arroz rica en vitamina A, confiaban en que su invento, el llamado arroz dorado, contribuiría de manera decisiva a resolver este problema. Pero los organismos genéticamente modificados han generado ansiedad en todo el mundo, y muchos gobiernos han prohibido su uso. Un episodio ocurrido en Filipinas ilustra bien esta reacción: en 2013, activistas contrarios a los transgénicos arrancaron plantas de arroz dorado capaces de salvar vidas, mientras agricultores consternados observaban la escena. Los reaccionarios protestaban contra una tecnología que consideraban parte de una conspiración destinada a subordinar la agricultura local a las grandes corporaciones multinacionales. En el momento de escribir estas líneas, el arroz dorado no ha alcanzado ni de lejos la adopción generalizada necesaria para salvar millones de vidas. Muchos siguen temiendo las consecuencias de manipular los genes de plantas y animales, pese a que los seres humanos llevan mucho tiempo practicando la selección artificial, una versión más torpe de la ingeniería genética.

Cuando se trata de intervenir en nuestros propios genes, sí debemos ser muy cautelosos por las implicaciones sociales que ello conlleva. Pero desde el punto de vista de la salud, la edición genética podría ser una bendición. CRISPR puede utilizarse para sustituir mutaciones concretas que causan enfermedades y ya ha mostrado un enorme potencial para curar a pacientes con anemia falciforme. Los investigadores confían en que algún día CRISPR pueda emplearse para corregir mutaciones responsables de trastornos genéticos más complejos o que aumentan la probabilidad de padecer cáncer. Esto podría hacerse incluso antes de que un niño nazca. En 2018, el científico chino He Jiankui conmocionó al mundo al anunciar que había utilizado CRISPR para modificar el código genético de los embriones de dos gemelas con el fin de hacerlas resistentes al VIH, y que esas niñas ya habían nacido. La comunidad científica condenó de manera unánime esta intervención temeraria en el genoma humano, realizada sin la debida supervisión ni una evaluación adecuada de los riesgos, y el profesor He fue encarcelado y desacreditado. No obstante, esta técnica podría llegar a ser ampliamente aceptada en el futuro debido a su extraordinario potencial para prevenir enfermedades.

Esta tecnología revolucionaria deberá ser regulada con sumo cuidado. Estamos más cerca que nunca de alcanzar el mundo feliz de Aldous Huxley, en el que los bebés son diseñados con determinadas características físicas y mentales. Si hoy ya existe resentimiento hacia las élites, basta imaginar lo que ocurriría si los ricos pudieran pagar un sobrecoste para tener hijos “perfectos”. Un mundo así pondría en cuestión uno de los principios fundamentales del liberalismo clásico: la idea de que todos los hombres y mujeres nacen iguales.

Así, aunque CRISPR y otros avances de la biotecnología encierran una promesa increíble, al igual que la inteligencia artificial también obligarán a una profunda reconsideración de lo que significa ser humano. El historiador Yuval Noah Harari sostiene que, pese a todos los cambios sociales, políticos y económicos a lo largo de los milenios, los Homo sapiens no han cambiado gran cosa ni física ni mentalmente… hasta ahora. La combinación de las dos revoluciones gemelas, la biológica y la informática, permitirá a los seres humanos ampliar sus capacidades físicas y mentales. El resultado, afirma, será la creación de un superhombre de rasgos casi divinos: Homo deus.

Más allá de la distopía

El futuro empieza a perfilarse. La tecnología podría transformar la sociedad de maneras que hoy ni siquiera somos capaces de imaginar. Neal Stephenson es un autor de ciencia ficción especialmente perspicaz: acuñó los términos “metaverso” para referirse a un mundo virtual y “avatar” para designar el yo digital de una persona. También ha imaginado cómo la inteligencia artificial podría transformar la experiencia humana. En su novela de 1995 The Diamond Age, un libro de cuentos “inteligente”, impulsado por IA, ayuda a una niña a salir de la pobreza, actuando como un tutor individual con paciencia infinita que la anima cuando pierde la esperanza. Cuando hoy muchas personas piensan en la IA y en los mundos digitales, su imaginación se dirige a distopías sombrías como Matrix, o a temores más prosaicos, como la adicción a los videojuegos o el desplazamiento de la vida real por la realidad virtual. Pero el relato de Stephenson —y las startups reales que están creando tutorías personalizadas mediante IA— muestra algunas de las posibilidades más optimistas de la inteligencia artificial. En otras épocas, solo unos pocos aristócratas podían permitirse un tutor privado; si la IA hace posible que cualquiera reciba una educación personalizada, será otro ejemplo de “cada hombre, un rey”.

Pero el cambio revolucionario es, por definición, profundamente disruptivo. La revolución de la información ha transformado el mundo de manera radical, y nuevos avances, potencialmente de mayor alcance aún, resultarán inquietantes. Muchos empleos desaparecerán, aunque la productividad global aumente, generando una riqueza mayor que podría beneficiar a todos. Se romperán normas, pero cabe esperar que la calidad de vida mejore para la mayoría. Existen preocupaciones reales en torno a la privacidad y preguntas legítimas sobre cómo deberían regularse, por parte de los gobiernos, tanto las empresas como a sí mismos frente a las tecnologías más avanzadas. Pero no se trata de problemas insolubles: podemos disfrutar de los beneficios de la vida digital y, al mismo tiempo, proteger nuestra privacidad y nuestra democracia. Y si somos capaces de desarrollar normas sensatas en torno a las revoluciones de la inteligencia artificial y la bioingeniería, tampoco perderemos nuestra humanidad. De hecho, quizá lleguemos a valorarla aún más. Eso sí, todo ello dará lugar a transformaciones todavía mayores en nuestra concepción de nosotros mismos y en nuestra idea de qué es lo específicamente humano.

Entre tanto alarmismo tecnológico, a menudo perdemos de vista su enorme potencial. Los antiguos anhelaban dispositivos que los liberaran del trabajo penoso y de la servidumbre. En su Política, Aristóteles imaginó una suerte de utopía en la que la esclavitud podría desaparecer: “Si cada herramienta pudiera realizar su tarea por sí misma, obedeciendo órdenes o anticipándose a ellas, y si, como las estatuas de Dédalo o los trípodes de Hefesto —que ‘acudían por sí solos a la asamblea de los dioses’—, los telares tejieran por sí mismos y las púas tocaran la lira, el maestro artesano no necesitaría ayudantes y los amos no necesitarían esclavos”. Hoy estamos más cerca que nunca de la visión de Aristóteles, de un mundo en el que tendremos que preguntarnos: ¿para qué sirven los seres humanos, si no es para el trabajo y la productividad? Y si los ordenadores con IA pueden ser mejores máquinas analíticas que el cerebro humano, ¿qué nos queda a nosotros? Probablemente empezaremos a definir nuestros rasgos distintivos como aquellos que se agrupan en torno a las emociones, la moral y, sobre todo, la sociabilidad: nuestra capacidad para trabajar, jugar y vivir con otros seres humanos. “El ser humano es, por naturaleza, un animal social”, escribió Aristóteles en esa misma obra hace dos mil años. Tal vez estemos regresando a esa sabiduría antigua.

Ningún país está siquiera cerca de una abundancia universal proporcionada por la automatización. Pero las revoluciones tecnológicas ya han generado una mayor productividad y riqueza, lo que ha ido desplazando lentamente las batallas políticas desde la economía hacia otros terrenos. La vieja división izquierda-derecha, centrada en el tamaño del Estado, ha dado paso a cuestiones de dignidad, estatus y respeto. Estamos pensando de otra manera qué nos define en lo más profundo —y cómo esa definición se proyecta en el ámbito social y político más amplio.

* Sobre el autor:

Fareed Zakaria (1964) es un analista político, ensayista y presentador estadounidense de origen indio, especializado en relaciones internacionales, política comparada y geopolítica. Doctor en Ciencias Políticas por Harvard, ha sido director de Newsweek International, editor de Foreign Affairs y columnista de The Washington Post. Conduce el programa Fareed Zakaria GPS en CNN desde 2008. Es autor de varios libros influyentes, entre ellos The Future of Freedom (2003), The Post-American World(2008) y Ten Lessons for a Post-Pandemic World (2020.

* Fuente: “Information Unbound Technology”, capítulo del libro Age of Revolutions. Progress and Backlash from 1600 to the Present (W. W. Norton & Company, Inc., 2024), de Fareed Zakaria