Internet es basura

Trabajadores subcontratados en San Francisco, procesando miles de quejas al día. Talleres en Filipinas donde mano de obra externalizada decide en cuestión de segundos qué es obsceno y qué es permisible. Equipos de ingenieros antispam en Mountain View, adaptándose a la última oleada de bots. Un moderador no remunerado en Reddit, seleccionando envíos que violan las directrices.

Gran parte de Internet es basura, y buena parte de su infraestructura y de miles de horas de trabajo humano se dedica a retirar esa basura. En su mayor parte, esta labor permanece oculta a simple vista. Pero en los últimos años, el sistema de gestión de residuos se ha venido abajo. Las empresas de redes sociales tienen un problema de acoso, han declarado los comentaristas.

Sin embargo, las campañas de acoso a gran escala no son en absoluto nuevas, y el aluvión de mensajes burdos y crueles y de contenido indeseable es solo una pequeña parte de lo que convierte una campaña dirigida en una experiencia aterradora para la víctima. Y aun así, esta parte de la ecuación —la parte que aparentemente está bajo el control de Silicon Valley— ha recibido la mayor atención mediática, porque es la más pública, visible y archivable. Y, a medida que las empresas tecnológicas fracasan repetidamente a la hora de abordar el problema de un modo satisfactorio para todos, este problema adquiere proporciones cada vez mayores en el imaginario público.

La comprensión pública del discurso en línea ha sufrido un cambio de paradigma profundo. Incluso en comunidades centradas en la tecnología, por lo general partidarias de la “libertad de expresión” en Internet, existe la sensación generalizada de que el acoso debe ser erradicado y resuelto. El anonimato y la libertad de expresión se han convertido en malas palabras, los lemas de una vieja guardia que se niega a abrir los ojos ante una crisis para Internet.

Pero ¿existe realmente una crisis y, de ser así, cuál es su naturaleza? Si Internet está bajo amenaza, en esencia lo está por la misma amenaza que ha existido desde su creación. Internet no se está rompiendo. Bajo las Wikipedias, los Facebooks, los YouTubes y otros brillantes depósitos de información, comunidad y cultura, Internet es —y siempre ha sido— en su mayor parte, basura.

Una teoría de la basura

¿Qué quiero decir con basura?

Es una categoría amplia, cuyos límites dependen enormemente del contexto. La definición cambia de una plataforma a otra, de un año a otro, incluso de una semana a otra.

La basura es simplemente contenido indeseable. Puede ser contenido pensado para quebrar el código del sitio. Puede ser malware. Puede ser spam en el sentido específico de texto comercial generado de forma robótica. Puede ser una “amenaza específica” dirigida a otro usuario. Puede ser una amenaza vaga. O puede ser una publicación salpicada con demasiadas palabras malsonantes. En las comunidades muy moderadas, las publicaciones consideradas simplemente fuera de tema pueden eliminarse. Las publicaciones que quizá no sean ni aterradoras, ni ofensivas, ni fuera de tema también pueden considerarse basura. En los foros de SomethingAwful, las publicaciones que se juzgan de escaso valor para la comunidad se llaman con el elocuente nombre de “publicación basura”.

Incluso en los espacios más anárquicos habrá contenido clasificado como basura. En 4chan, un sitio con fama de permitir “cualquier cosa”, el doxing (publicar direcciones u otra información personal sin permiso) y los “forum raids” (orquestar una campaña de vandalismo o acoso en otro sitio) están prohibidos. En Silk Road, un servicio oculto en Tor que permitía comprar y vender drogas, se prohibían los anuncios de armas. En ambos sitios, la pornografía infantil está —y estuvo— prohibida.

Por muy libertario, permisivo o ilegal que sea un sitio, siempre hay contenido considerado indigno de permanecer en él. Debe ser eliminado. Quizá porque es contenido ilegal (por ejemplo, pornografía infantil). Quizá porque es peligroso para otros usuarios (por ejemplo, malware). Y quizá simplemente porque no encaja con la declaración de objetivos de la comunidad: es decir, se desvía de los propósitos y metas de la plataforma. Ya sea una comunidad de personas afines (tablones de anuncios, foros y listas de correo) o una empresa de redes sociales orientada al lucro (Facebook, Twitter, Instagram), siempre hay contenido que hace la plataforma simplemente menos buena. Los criterios de lo “bueno” difieren, pero la regla es la misma: parte del contenido aporta valor; otra parte lo resta. Cada rincón de Internet trabaja activamente para desincentivar o eliminar la basura; de lo contrario, la basura lo atascará y lo matará.

Spam como basura

Hoy, nada es tan indiscutiblemente basura como el spam. Y aun así, la definición de spam es nebulosa. En 1975, Jon Postel —un científico de la computación con tal nivel de control y prestigio en los primeros tiempos de Internet que llegó a ser conocido como el “Dios de Internet” antes de su muerte en 1998— escribió el documento “On the Junk Mail Problem”. El “problema” que abordaba el documento RFC 706 era en realidad de carácter especulativo, y el “correo basura” se describía como material “indeseado”, “que se comporta mal” o “simplemente molesto”.

El término “spam”, que hoy es intercambiable con “correo basura”, empezó siendo simplemente un comportamiento molesto. En los primeros sistemas de chat, los usuarios solían escribir “spam, spam, spam, spammity spam”, una referencia a un sketch de Monty Python en el que el desayuno de una pareja es interrumpido constantemente por unos vikingos que cantan sobre el spam. Si los usuarios pulsaban la flecha hacia arriba, la línea se replicaba, y podían “spamear” la sala una y otra vez con muy poco esfuerzo. Finn Brunton, profesor de medios, cultura y comunicación en la Universidad de Nueva York, escribe en Spam: A Shadow History of the Internet:

“En un espacio limitado por el ancho de banda, solo de texto, donde seguías los intercambios línea por línea en un monitor monocromo, esto era una herramienta poderosa para molestar a la gente. Podías empujar toda la conversación hacia arriba y fuera de la pantalla, cortando a otros usuarios y dominando esa conexión dolorosamente lenta. […] La palabra ‘spam’ servía para identificar una forma de pensar y actuar en línea que era perezosa, indiscriminada y un desperdicio del tiempo y la atención de los demás”.

En los primeros años, de hecho, no estaba nada claro que el spam debiera eliminarse o filtrarse de forma proactiva. El debate se planteaba como un asunto de libertad de expresión, donde la postura más libertaria, según Brunton, era la que permitía “cualquier discurso excepto aquel que interfiera activamente con la capacidad de Usenet para funcionar —es decir, aquello que restrinja el discurso de otros”. Para Brunton, esto queda mejor resumido en el “An Alternative Primer on Net Abuse, Free Speech, and Usenet”, de Dave Hayes, publicado en 1996:

“Ejemplo de abuso en la red:

– Publicar artículos que hacen que el servidor de noticias encargado de inyectar el post en el flujo de noticias se bloquee directamente.

– Publicar artículos que contienen mensajes de control diseñados para bloquear servidores de noticias.

– Hackear directamente un servidor de noticias para desactivarlo.

Ejemplos de cosas que NO son abuso en la red:

– Publicaciones voluminosas [sic]

– SPAM

– Publicar lo mismo en varios foros

– Publicaciones fuera de tema

– Publicar mensajes incendiarios o entrar en discusiones acaloradas”

Ya en los años 2000, generadores comerciales de spam, como Laura Betterly, se defendían alegando que enviar millones de mensajes no solicitados era “sobre lo que se construyeron los Estados Unidos. Los pequeños emprendedores tienen derecho al marketing directo”. De hecho, caracterizaban la reacción virulenta contra el spam como “grupos de odio que están intentando acabar con el correo comercial”.

Hoy, sin embargo, el spam se entiende sobre todo como texto generado de forma robótica, emitido desde “botnets” de ordenadores comprometidos que han sido reclutados sin saberlo para transmitir cantidades asombrosas de mensajes no deseados anunciando Viagra, aumentos genitales, estafas nigerianas para hacerse rico rápidamente o enlaces a malware diseñados para robar contraseñas o simplemente reclutar otro ordenador más para la horda zombi mecánica. El spam se ha convertido en el reino de redes criminales rusas (como ha documentado Brian Krebs en numerosos lugares, incluido su libro Spam Nation), una industria multimillonaria combatida, a su vez, mediante miles de millones de dólares invertidos en tecnología antispam.

Por supuesto, la antigua definición de spam aún persiste. Por ejemplo, alguien puede ser reprendido por “spamear una lista de correo” cuando no es un robot intentando evadir un filtro, ni un remitente comercial anunciando un producto o servicio. Pero, poco a poco, el spam está adquiriendo una definición relativamente estrecha. Es aquello que cae en el filtro de spam y que queremos que caiga en el filtro de spam: el texto poético y confuso procedente de direcciones extrañas, lleno de palabras mal escritas y enlaces sospechosos.

La profunda ambigüedad de la palabra “spam” en los primeros tiempos recuerda lo nebuloso que es hoy el término “acoso”. Mientras los medios se centran en campañas discretas y fácilmente identificables de odio contra mujeres como Caroline Criado-Perez en 2013, Anita Sarkeesian en 2012 o Kathy Sierra en 2007, el peor acoso suele producirse en circunstancias mucho más complejas. Cuando linchamientos digitales como Gamergate se intensifican, el término “acoso” se lanza de un lado a otro como acusación, con ambos bandos convencidos de que el otro es el verdadero acosador y que ese bando está utilizando el término de mala fe para aplicarlo a simples críticas o a un lenguaje apenas desagradable.

No quiero decir que no exista tal cosa como el acoso, del mismo modo que no creo que no exista la violencia de pareja, aun cuando sea habitual que los maltratadores domésticos afirmen que sus víctimas son quienes les están maltratando a ellos. Pero la palabra, cuando se usa, suele carecer de una base específica. Igual que ocurrió con “spam”, a menudo significa simplemente un mensaje indeseado. Estamos en los primeros días de comprender el “acoso” como una subcategoría de basura. Así como el spam solía ser un cajón de sastre para muchos tipos distintos de desechos, el acoso también se ha convertido en un cajón de sastre. Pero si queremos combatirlo, debemos mejorar la definición.

II. Sobre el acoso

Acoso en las noticias

Con la atención internacional puesta en la avalancha de amenazas enviadas por Twitter a Caroline Criado-Perez en 2013 (y la posterior condena de algunas de las personas que se las enviaron), y con la creciente cobertura mediática de otros incidentes, el término “acoso” se utiliza cada vez con más frecuencia. La palabra sigue estando mal definida, pero suele entenderse en relación con las siguientes campañas de alto perfil.

Caroline Criado-Perez

En 2013, Caroline Criado-Perez pidió que una mujer apareciera en un billete inglés. Ganó: Jane Austen sustituyó a Charles Darwin en el billete de diez libras. Entonces comenzó el acoso. Según Criado-Perez, se le enviaban 50 tuits por hora, incluidas amenazas de violación. A rebufo de una gran historia mediática (el cambio del billete), esta tormenta online recibió una atención masiva en la prensa. Dos usuarios fueron condenados a prisión por el caso. Habían tuiteado cosas como:

- “que te jodan y muérete, pedazo de basura inútil”

- “vete a matarte”

- “La violación es lo que menos debería preocuparte”

- “cállate, zorra”

- “No eres tan guapa como para violarte, estarías bien”

- “te encontraré [cara sonriente]”

- “violen su lindo culo”

Anita Sarkeesian

Anita Sarkeesian es una crítica cultural que logró recaudar fondos mediante micromecenazgo para realizar una serie de vídeos en YouTube sobre los tópicos sexistas en los videojuegos. Junto con una recepción positiva, también hubo una reacción prolongada y claramente desproporcionada, que Adi Robertson en The Verge describió como:

“una campaña incesante y profundamente paranoica contra Tropes vs. Women en general y contra Sarkeesian en particular. Incluye una avalancha de comentarios violentos y correos electrónicos, vídeos que documentan las maneras en que ella no es una ‘verdadera gamer’, un juego en el que se puede golpearla en la cara, y un documental propuesto para exponer las ‘mentiras’ y la ‘campaña de desinformación’ de lo que, al fin y al cabo, es un conjunto de opiniones sobre videojuegos”.

Sarkeesian documentó los comentarios que recibía en YouTube. Lo siguiente es una muestra muy pequeña (elegida al azar) de una cantidad muchísimo mayor:

- “qué fea eres, zorra feminazi”

- “ojalá te violen”

- “alguien debería matarte”

- “vete a lavar platos en lugar de arruinar videojuegos”

- “cállate, puta”

- “nadie quiere oír tus mentiras, muérete ya”

- “si te veo, te reviento la cara”

- – “Odio los ovarios con un cerebro lo bastante grande como para subir vídeos”

- – “Bromas aparte, se olvidó por completo de mencionar que todos los tíos en los videojuegos tienen también estos estereotipos. ¿Nos ves a nosotros montando un escándalo por eso? No, cariño, es un videojuego”

- – “tetas o lárgate a la mierda”

- – “Sí, estoy deseando que llegue el día en que podamos jugar a ‘feminista gorda y fea: el juego’. Ese sí vendería millones de unidades”

- – “¿Pedir dinero por hacer un puto blog? Y lo haces de una forma en que las mujeres deberían pagar para no ser dominadas por los hombres. Plan inteligente y malvado. Tú eres la razón por la que las mujeres han sido el género inferior durante toda la historia de la humanidad”

- – “vuelve a la cocina, zorra”

- – “qué tía más estirada. Ojalá toda esa gente que le dio dinero sea violada y muera de cáncer”

- – “Ahahahahahahha qué IDIOTA más estúpida!!!!!!”

- – “Yo le daría dinero para que DEJE de hacer vídeos. Le quita la alegría a todo y tiene esa expresión perpetua de ‘oler un pedo’, esa cara miserable”

Y, entre toda esa avalancha:

– “Estoy de acuerdo con esto y creo que todo el mundo también lo está. Caso cerrado”

Sarkeesian escribió:

“Además del torrente de misoginia y odio que dejaron en mi vídeo de YouTube (ver más abajo), el esfuerzo de intimidación también ha incluido vandalizar repetidamente mi página de Wikipedia (con porno), esfuerzos organizados para marcar mis vídeos en YouTube como “terrorismo”, así como muchos mensajes amenazantes enviados a través de Twitter, Facebook, Kickstarter, correo electrónico y mi propio sitio web. Estos mensajes y comentarios han incluido desde los chistes típicos del sándwich y la cocina hasta amenazas de violencia, muerte, agresión sexual y violación. Todo eso, más un intento organizado de denunciar este proyecto a Kickstarter para que fuera prohibido o se le retirara la financiación.”

En 2012, Sarkeesian publicó su primer vídeo. En agosto de 2014, se vio obligada a huir de su casa tras recibir una amenaza. En octubre de ese mismo año, canceló una conferencia en la Universidad Estatal de Utah después de que alguien enviara un mensaje al centro afirmando que cometería “el tiroteo escolar más mortífero de la historia de Estados Unidos” si se permitía a Sarkeesian hablar.

Amanda Hess

Amanda Hess, periodista que escribe con frecuencia sobre feminismo y cuestiones relacionadas con las mujeres, publicó un ensayo personal en la revista Pacific Standard sobre los abusos que sufría en Internet. El texto recibió una enorme atención pública y terminó otorgándole un premio. En uno de los ejemplos del acoso que recibió, relata:

“Alguien con el nombre de usuario headlessfemalepig[1] me había enviado siete tuits. ‘Veo que físicamente no eres muy atractiva. Me lo imaginaba’, decía el primero. Luego: ‘Se la chupas a un montón de tíos borrachos y colocados’. Como periodista mujer que escribe sobre sexo (entre otras cosas), ninguno de estos comentarios era especialmente extraordinario. Pero este tipo fue más allá: ‘Tengo 36 años, cumplí 12 por homicidio involuntario, maté a una mujer, como tú, que decidió burlarse de las pollas de los tíos’. Y después: ‘Qué bien que vivamos en el mismo Estado. Te estoy buscando, y cuando te encuentre voy a violarte y arrancarte la cabeza’. Hubo más, pero el tuit final lo dejaba claro: ‘Vas a morir y yo soy quien te va a matar. Te lo prometo’.”

Hess acudió a la policía, pero el agente con el que habló ni siquiera sabía qué era Twitter, y no se tomó nada en serio. Para Hess, aquello fue un fracaso del sistema legal. Sabía que existía un problema estructural en toda la industria, un problema con dimensión de género, y lo sabía porque sus colegas enfrentaban lo mismo. “Nada de esto me hace excepcional”, escribió. “Solo me convierte en una mujer con conexión a Internet.”

Zoe Quinn

Zoe Quinn se sitúa en el centro de una enorme conflagración que atravesó toda la industria del videojuego, conocida como Gamergate. Para el observador casual no es inmediatamente evidente de qué va Gamergate ni por qué Quinn ocupa un lugar tan central. Como fenómeno, Gamergate se caracteriza por un acoso constante y de baja intensidad en redes sociales, salpicado por doxes maliciosos (la publicación no consensuada de datos privados como direcciones físicas, números de la Seguridad Social, etc.). Mucha gente —desarrolladores, periodistas de videojuegos y usuarios corrientes de la comunidad— ha sido arrastrada al conflicto simplemente por expresar opiniones en un sentido o en otro. Ambos bandos han afirmado haber sido acosados y ambos han acusado al contrario de inventarse ese acoso.

El eslogan de Gamergate —que a estas alturas es ya una fuente de humor negro en Internet— es “ética en el periodismo”. Quinn, desarrolladora independiente, fue acusada de muchas cosas, entre ellas de intercambiar favores sexuales por críticas positivas de su juego Depression Quest. (El hombre con el que supuestamente se acostó ni siquiera reseñó su juego). El “zumbido ambiental de amenaza” en la vida de Quinn tiene menos que ver con cómo su pequeño juego independiente arruinó para siempre el género de los videojuegos y mucho más con su supuesta actividad sexual (un tema que aparece una y otra vez cuando se acosa a mujeres).

Hay mucho que decir sobre Gamergate como plantilla de un nuevo tipo de guerra cultural, y como signo de una nueva era en los videojuegos, una que algunos han llamado “la muerte de los gamers”. El fenómeno ha expulsado a mujeres del desarrollo de videojuegos y del periodismo especializado. Ha hecho más visible el término “guerrero de la justicia social” —o SJW—. La etiqueta SJW nace de la idea de que quienes critican la falta de diversidad en los videojuegos son el enemigo: una especie de maquinaria cultural con un supuesto control férreo sobre los medios, que debe ser combatida. Gamergate, como fuerza, se alinea contra todos aquellos a quienes perciben como SJWs. Qué tiene que ver todo esto con Zoe Quinn no es especialmente obvio.

Gamergate es complicado. Y también es bastante simple: es una campaña de acoso instigada por el exnovio de Quinn, Eron Gjoni. Quinn ya sufría acoso antes de Gjoni, pero su ex lo amplificó de manera exponencial. “Antes del post de Gjoni, había recibido 16 megabytes de acosos. Cuando dejó de guardar amenazas en diciembre de 2014 —porque no podía seguir el ritmo— tenía 16 gigabytes: mil veces más.”

Quinn y Gjoni salieron juntos cinco meses. Tras la ruptura, él creó “The Zoe Post”, una entrada de blog donde afirmaba que ella le había sido infiel. Un perfil de Boston Magazine sobre Gjoni afirma: “Cuando publicó el post a lo loco, calculaba que había un 80% de probabilidades de que Quinn fuera acosada”.

Tenía razón. Quinn recibió una avalancha de mensajes amenazantes, como:

- “Si alguna vez te veo haciendo un pannel [sic] en un evento al que voy, te voy a matar literalmente. No vales ni mierda y mereces ser herida, mutilada, asesinada y, finalmente, bendecida con mi meada sobre tu cadáver podrido mil veces”.

Quinn fue doxeada: su información personal, incluida su dirección y su número de la Seguridad Social, se hizo pública. Se mudó. El acoso continuó… y con una investigación paciente, Quinn pudo documentar cómo Gjoni animaba a los acosadores desde las sombras. Lo que Gjoni estaba haciendo era a la vez complicado y simple, viejo y nuevo. Había logrado tercerizar el abuso doméstico.

Kathy Sierra

Después de los ejemplos anteriores, la historia de Kathy Sierra puede sonar repetitiva. Pero lo que le ocurrió —ella, autora y bloguera de tecnología— sucedió en 2007, mucho antes de la actual ola de interés por el acoso de género. Al principio solo recibía mensajes, mensajes muy parecidos a los que recibieron Quinn, Criado-Perez, Sarkeesian y Hess.

- “Lárgate, puta aburrida… espero que alguien te raje el cuello y te meta las tripas por la boca”

- “Más te vale mirar por encima del hombro en la calle, zorra… Sería una lástima que aparecieras en la cuneta, donde perteneces, con un machete metido en ese coño santurrón tuyo”

- “Lo único que Kathy Sierra tiene que ofrecerme es una soga de la talla de su cuello”

Después llegó el doxing: una publicación seudónima que difundió su número de la Seguridad Social y su dirección. Se acompañaba de una biografía inventada que repetía las acusaciones de “The Zoe Post”: que se había hecho cirugía estética, que había engañado a su exmarido, que se había dedicado a la prostitución. Las amenazas se intensificaron. Sierra se mudó al otro lado del país.

Hay enormes partes de su historia de las que no quiere hablar públicamente, y es comprensible. De hecho, es profundamente inusual que Sierra haya hecho pública siquiera una parte del acoso que sufrió. Quienes son blanco de estas campañas tienden a silenciarse por miedo a más abusos. Y ese miedo no es infundado: un patrón constante es que el acoso aumenta cuanto más se habla de él. Por eso lo peor de lo que reciben permanece oculto a la vista del público. Pero cuando alguien es doxeada tan abiertamente, es fácil imaginar a qué se enfrenta.

Sobre el relato mediático…

La primera mención de Kathy Sierra en The New York Times, en 2007, no habla demasiado de cómo el acoso destrozó su vida. Más bien se centra en los “abucheos en línea”, los “comentarios anónimos”, la “vitriolo” y las “amenazas de asfixia, violación y linchamiento”.

En el relato mediático, el acoso se reduce a palabras: amenazas de violación y de bomba, enviadas por desconocidos anónimos a mujeres que “no han hecho nada para merecerlo”. Para quienes jamás se comportarían así, el mero hecho de que ocurra resulta desconcertante.

Para Sierra, ella y otras mujeres son atacadas porque tienen visibilidad:

“El verdadero problema —como describió mi primer acosador— era que otros empezaban a prestarme atención. Escribía como si la mera exposición a mi trabajo estuviera dañando su mundo.

[…]

Ahora creo que el momento más peligroso para una mujer con visibilidad online es cuando sus seguidores empiezan a prestarle atención de verdad, escuchándola, siguiéndola, dándole ‘me gusta’, marcando como favorito, retuiteando. A partir de ahí, en la mente del acosador, ese interés del público ‘ya es demasiado’.

Lo que les ocurrió a Sierra, a Quinn, a Hess, a Sarkeesian y a Criado-Perez es aterrador, absurdo e imperdonable. Pero también es un microcosmos muy pequeño del acoso en línea. Estos son los ejemplos más limpios, simples y directos de acoso. Las mujeres tienen nombres y reputación, y cuentan con audiencias que las escuchan. Sus atacantes son anónimos. La agresión puede documentarse. Y la brutalidad del ataque no parece “justificada”. Precisamente porque sus historias encajan en este patrón, son las que reciben mayor atención mediática.

Hoy Sierra es muy reflexiva sobre este fenómeno. Ve abusos sostenidos por todas partes, ocultos y fuera de la vista, simplemente porque al público le “parece lógico” que ese blanco esté siendo acosado. En una entrevista con Benjamen Walker, en su pódcast “Theory of Everything”, dijo:

“Probablemente el momento más surrealista de mi vida fue estar sentada en un restaurante con mis hijas, y había CNN puesta en ese bar deportivo, y allí estaba Michelle Malkin diciendo: ‘Bueno, ¿dónde diablos estaba todo el mundo cuando yo recibía todas mis amenazas de muerte? Una simple bloguera tecnológica recibe amenazas de muerte y, oh dios mío’. Y pensé: ‘Sí, pero ¿qué esperas?’ No es sorprendente, por las cosas que ella dice. Por supuesto, ahora me horroriza haber pensado eso. Pero es una reacción natural. Y, de nuevo, creo que el hecho de que la gente no pudiera hacer eso conmigo es exactamente la razón por la que se convirtió en una historia que atrapó la atención de tanta gente. Porque seguían preguntando: ‘¿Qué hizo? ¿Qué hizo? ¿De qué habló para cabrearlos?’ Y después no podían averiguarlo. Porque no había nada”.

La manera en que los medios encuadraron la campaña de acoso contra Sierra también refleja un segundo sesgo en la imaginación pública. The New York Times ha mencionado la palabra “doxing” tres veces. Las tres se refieren a hombres, y en al menos una, el término está mal empleado. En el relato mediático, el acoso se convierte en palabras descontroladas, no en números de la Seguridad Social. Se convierte en amenazas de violación, pero no en la publicación de direcciones físicas. Se convierte en oleadas y oleadas de tuits aterradores, pero no en un equipo SWAT irrumpiendo en tu puerta porque alguien en Internet llamó a la policía con una amenaza falsa.

Y por último, los acosadores casi siempre se presentan como desconocidos anónimos. Aunque el principal acosador de Kathy Sierra, Andrew Auernheimer, siempre ha tenido su nombre legal vinculado a su seudónimo en línea, “weev”. Aunque la campaña contra Quinn comenzó —y fue alimentada— por una expareja.

A pesar de la creciente preocupación pública por los blancos del acoso en línea de género, el acoso sigue representándose como un daño efímero infligido por entidades fantasmales. Pero no lo es. Abarca un espectro vastísimo que incluye violencia de pareja, acecho, invasión de la privacidad, pirateo informático e incluso agresiones físicas.

¿El acoso está generizado?

Me centro aquí en el acoso de carácter de género por una buena razón. Existe una cantidad considerable de documentación que indica que el acoso en línea afecta de manera desproporcionada a las mujeres. En la siguiente sección revisaré parte de la bibliografía, en su mayor parte recogida en Hate Crimes in Cyberspace, de Danielle Citron. Estos estudios, en cierta medida, coinciden con relatos anecdóticos y con mi propia experiencia personal. Pero también hay buenas razones para estar atentos a futuras investigaciones sobre el tema, razones que desarrollaré más abajo.

La National Violence Against Women Survey de EE. UU. estima que el 60% de las víctimas de “ciberacoso” son mujeres. El National Center for Victims of Crime calcula que en realidad las mujeres representan el 70%. La organización Working to Halt Online Abuse (WHOA) recopiló información de más de 3000 denuncias de “acoso en línea” entre 2000 y 2011 y concluyó que el 72,5% eran mujeres. La Bureau of Justice Statistics informa de que el 74% de las personas acosadas —en línea o fuera de ella— son mujeres. Entre 1996 y 2000, la mayoría de las víctimas de acoso agravado atendidas por la Computer Investigation and Technology Unit (CITU) del Departamento de Policía de Nueva York eran mujeres.

En 2006, unos investigadores introdujeron bots silenciosos en Internet Relay Chat. Los bots con nombres “femeninos” recibieron 25 veces más “mensajes privados maliciosos” (definidos como “lenguaje sexual explícito o amenazante”) que los bots con nombres “masculinos”.

Experimentos casuales, no académicos y menos controlados arrojan resultados similares. Como describo en la siguiente sección, algunos usuarios de Twitter han experimentado cambiando sus avatares para reflejar distintos géneros o razas. Hombres que se hicieron pasar por mujeres descubrieron abruptamente que ahora eran objeto de una lluvia constante de comentarios maliciosos o simplemente desagradables. Un hombre creó un perfil femenino en la aplicación de citas Tinder que no hacía más que aceptar coincidencias en silencio. En apenas unas horas, hombres le habían llamado “zorra” y le habían dicho que “se fuera a [matarse]”.

Las mujeres relatan con frecuencia pruebas anecdóticas de que cambiar su avatar por cualquier cosa que no fuera una foto de su rostro (incluso si era un dibujo de su propio rostro) reducía drásticamente los mensajes hostiles que recibían.

Intersecciones del acoso

Pero estos estudios, estadísticas y anécdotas necesitan ser interrogados con mucha más profundidad. Hay un hallazgo disidente notable, aunque no puede tomarse en serio: un estudio de 2014 (el estudio Demos) que examinó una muestra de 65 celebridades británicas durante dos semanas y concluyó que la gente enviaba más mensajes groseros a los hombres que a las mujeres. El estudio Demos debe descartarse por completo únicamente debido a la muestra: demasiado pequeña, tomada de un grupo minoritario atípico (celebridades) y “calibrada” por razones poco sólidas (las celebridades se seleccionaron para que el número de tuits dirigidos a hombres y mujeres fuera igual).

Los resultados del estudio de Demos no pueden extrapolarse de buena fe a un ámbito más amplio, pero, por otro lado, es un estudio que no depende de la autodeclaración de las víctimas. Los ejemplos anteriores, salvo el estudio del bot en IRC, sí lo hacen. La autodeclaración puede producir resultados sesgados, no porque las mujeres sean quejicas o más sensibles, sino porque el encuadre del problema puede resonar o no de la misma manera en todos los grupos, o porque determinadas víctimas evitan activamente interactuar con la entidad que recopila los datos.

Por ejemplo, Danielle Citron señala que un estudio de 2009 con 992 estudiantes universitarios concluyó que “las mujeres no blancas se enfrentaban a más ciberacoso que cualquier otro grupo, con un 53% declarando haber sufrido acoso en línea. Les seguían las mujeres blancas, con un 45%, y los hombres no blancos, con solo un 31%”.

Pero Citron añade a continuación: “No hay pruebas claras de que la raza sea un factor determinante”, ya que, según la Bureau of Justice Statistics y los casos cerrados por la Computer Investigation and Technology Unit (CITU) del Departamento de Policía de Nueva York, la mayoría de las víctimas de ciberacoso son mujeres blancas. No es difícil imaginar que las personas racializadas sean menos propensas a acudir a la policía.

Citron denuncia que las víctimas son reacias a denunciar por la (no injustificada) percepción de que sus preocupaciones no serán tomadas en serio. Pero no entra a analizar si esta percepción puede variar de una persona a otra según la raza o incluso el género, o si podría estar vinculada a la manera en que alguien identifica un episodio de acoso en línea bajo la etiqueta de “acoso en línea” (o la expresión que utilice el estudio o la agencia policial).

Las investigadoras Alice Marwick y danah boyd, por ejemplo, han descubierto que los adolescentes identifican casos de acoso escolar en línea como “drama”: el término “ciberacoso” no “resuena” con ellos. “Ciberacoso” es un término de adultos. De manera similar, es posible que la expresión “acoso en línea” sea una que emplea con mayor frecuencia un determinado grupo para describir sus experiencias, aunque otros grupos sufran por igual exactamente las mismas conductas.

Dada la notable coherencia de los estudios sobre acoso en línea y mujeres, sería toda una sorpresa descubrir que los hombres, después de todo, se ven afectados por igual. Aunque se necesitan más estudios, es muy probable que sigan apoyando la tesis de que las mujeres son impactadas de forma desproporcionada. Pero los estudios futuros tendrán mucho que aportar sobre otros aspectos del acoso que hoy se dan por supuestos. Por ejemplo, Citron afirma que la mayoría de los acosadores no tienen “ninguna conexión personal con” su víctima, basándose en un estudio de WHOA. Pero este resultado parece precisamente el tipo de hallazgo que podría verse afectado por el efecto “ciberacoso”/“drama”. Los estudios venideros también aclararán previsiblemente cómo otros ejes de opresión influyen en el acoso.

Sostengo que el acoso se ve amplificado por muchos factores, entre ellos la identidad de género, la raza y la orientación sexual. Formulo esta afirmación basándome en algunas pruebas empíricas y en una gran cantidad de observación personal. He optado por analizar en profundidad el género y la misoginia en línea porque los relatos sobre mujeres (blancas, heterosexuales, cisgénero, “respetables”) han contribuido a hacer más visible el debate sobre el acoso en línea. Y en parte por ello, la literatura sobre el acoso como fuerza social opresiva es bastante sólida en lo referente al género, y menos sólida en lo referido a otras intersecciones de identidad y opresión.

Por el bien del futuro de Internet, deberían realizarse más estudios sobre este tema, y pronto. Pero hasta que se publique más literatura, me limitaré a describir el experimento del “cambio de raza”.

En 2014, la escritora Jamie Golden Nesbitt —negra, mujer, y reconocible como tal en su avatar de Twitter— cambió su avatar por la foto de un hombre blanco. Notó un cambio inmediato en la cantidad de acoso que recibía. La escritora Mikki Kendall (también negra, mujer y reconocible en su avatar) hizo lo mismo y sugirió que otras personas experimentaran cambiando sus avatares para reflejar distintas razas y géneros: esencialmente, ponerse en la piel de otra persona.

Para Kendall, que normalmente recibía decenas de tuits vitriólicos al día, el cambio fue notable. Al tratar temas controvertidos, tenía menos probabilidades de convertirse en blanco de comentarios abusivos y, en su lugar, recibía respuestas “razonables”, “calmadas” y “curiosas”, incluso de las mismas personas que la habían trolleado con ferocidad en el pasado. Kendall dijo en el programa de radio On The Media: “Seguí recibiendo algún comentario airado, pero ninguno tenía carga de género ni carga racial. Era más probable algo como ‘Ah, eres un idiota’, o ‘Eres un imbécil’. Ese tipo de cosas”.

Cuando escritores blancos y hombres usaron avatares de mujeres blancas o de personas racializadas, quedaron consternados por el cambio. Al menos uno tuvo que volver a su avatar original después de dos horas.

Quiero hacer dos observaciones sobre interseccionalidad y acoso:

En primer lugar, las personas que son visiblemente identificables como pertenecientes a una raza o género marginado experimentan un Internet completamente distinto. Es un Internet más desagradable, más extenuante, que se vuelve aún más desagradable y aún más extenuante conforme se acumulan las intersecciones. Conviene recordarlo, especialmente porque las narrativas mediáticas sobre las formas “peores” de acoso rara vez incluyen a personas racializadas.

En segundo lugar, las intersecciones influyen en cómo diseñar políticas públicas. Las medidas contra el acoso deben orientarse a proteger a quienes son más vulnerables. ¿Qué sentido tiene, por ejemplo, priorizar la formación de la policía si quienes están más expuestos en Internet (por ejemplo, personas transgénero, trabajadoras sexuales y/o personas racializadas) son quienes menos probabilidades tienen de llamar a la policía? ¿Cómo se mitiga la humillación sexual mediante fotos desnudas si la persona atacada es una trabajadora sexual?

Estas son consideraciones que espero que los lectores tengan presentes. Un enfoque uniforme basado en la narrativa mediática dominante tendrá, con toda seguridad, consecuencias no deseadas para quienes no aparecen en los titulares.

Sobre el doxing

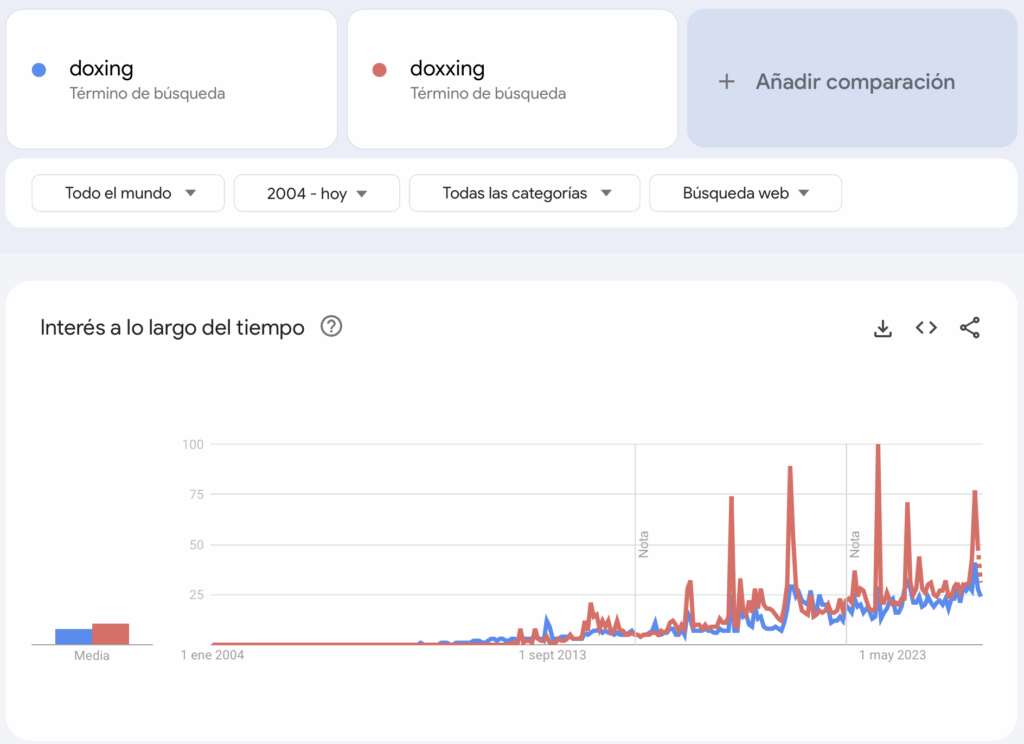

El doxing, mencionado brevemente más arriba, es una subcategoría del acoso. Y, al igual que “acoso”, la palabra “doxing” (a veces escrita “doxxing”) está mal definida. Bruce Schneier, experto en seguridad, la define así:

“Para quienes no estén familiarizados con la cultura hacker, quizá sea necesaria una explicación de ‘doxing’. La palabra se refiere a la práctica de publicar información personal sobre personas sin su consentimiento. Normalmente son cosas como direcciones y números de teléfono, pero también pueden ser datos de tarjetas de crédito, información médica, correos privados… prácticamente cualquier cosa que un agresor pueda conseguir.

El doxing no es nuevo; el término se remonta a 2001 y al grupo hacker Anonymous. Pero puede resultar increíblemente ofensivo. En 2014, varias mujeres fueron objeto de doxing por parte de jugadores varones que trataban de intimidarlas para que guardaran silencio sobre el sexismo en los videojuegos”.

La definición estricta de “hacker” de “dropping dox”, como se formuló inicialmente, implica publicar documentación (o “docs”/“dox”). Como señala Schneier, puede tratarse de direcciones, números de teléfono, información financiera, historiales médicos, correos electrónicos, etc. La parte en la que la definición de “doxing” se vuelve confusa es que las apariciones más destacadas de la palabra en los medios no han implicado en absoluto la publicación de datos personales. Más bien, en ocasiones, ha pasado a significar desenmascarar a usuarios anónimos de Internet sin su consentimiento. La palabra irrumpió en el discurso general en 2012 (aunque ya había aparecido en algunos artículos en 2011), como recogió The New York Times en su lista de “Words of 2012”, que incluía lo siguiente:

“DOX: Encontrar y divulgar toda la información disponible sobre una persona u organización, normalmente con el propósito de exponer su identidad o sus secretos. ‘Dox’ es una abreviatura consolidada de ‘documents’ o ‘to document’, especialmente en sectores tecnológicos. En 2012, el usuario destacado de Reddit Violentacrez fue ‘doxeado’ por Adrian Chen en Gawker para exponer comportamientos cuestionables”.

En 2012, Adrian Chen publicó un artículo exponiendo el nombre legal del usuario de Reddit Violentacrez, moderador de varios subreddits como r/creepshots y r/jailbait (asociados a fotos de mujeres tomadas sin su consentimiento o a imágenes potencialmente ilegales). Aunque su artículo daba el nombre, la ocupación y la ciudad de residencia de Michael Brutsch, alias Violentacrez, nada de lo escrito constituía realmente un “dropping dox” sobre Brutsch. Ni su dirección, ni su número de teléfono, ni su número de la Seguridad Social fueron expuestos. Sin embargo, la reacción al artículo de Chen, particularmente en Reddit, fue profundamente virulenta. Muchos subreddits siguen imponiendo un embargo a los enlaces de Gawker, y una de las normas históricas aplicables a todo Reddit impone una prohibición de publicar información personal, explicando:

“NO PERMITIDO: Publicar el nombre completo, el empleador u otros datos de la vida real de otro redditor”.

La idea de que un “nombre completo” puede constituir un dox refleja la comprensión de que, en algunos contextos, la publicación de un nombre legal funciona como un llamamiento a que otros completen el dox. A través de Google y otras bases de datos, un nombre completo puede conducir a otros datos: una cuenta en redes sociales que revela más información, fotos de los hijos, una dirección de trabajo, incluso una dirección personal. Información como direcciones, números de teléfono y lugares de trabajo ha estado disponible públicamente durante mucho tiempo. Pero, como señala la socióloga y escritora Katherine Cross, “se subestiman los efectos multiplicadores únicos de Internet. Hay una diferencia entre información enterrada en letra pequeña en un libro denso del que existen solo unos pocos miles de copias en un ámbito geográfico limitado, y difundir esos datos en línea, donde cualquiera con una conexión en cualquier parte del mundo puede acceder a ellos”.

El contexto en el que se publica la información pública importa. Cuando el dox se publica “ante una audiencia previamente hostil”, la probabilidad de que se desencadene una acción maliciosa es mucho mayor. Katherine Cross lo denomina “acoso por crowdsourcing”. En palabras de Kathy Sierra:

“Ese es el asunto: no se trata tanto de la gran REVELACIÓN, sino del contexto en el que se produce esa revelación: donde alguien espera agitar a otros hasta el frenesí, confiando en que al menos algunos de ellos estarán lo bastante enfadados y/o desequilibrados como para pasar a la acción. El troll no tiene que ensuciarse las manos, porque sabe que otro lo hará por él”.

Kathy Sierra fue objeto de doxing total, lo que significa que se publicó su número de la Seguridad Social. Sin embargo, el término “dox” no se asoció a lo que le ocurrió hasta muchos años después. La persona considerada en gran medida responsable de la divulgación inicial, Andrew “weev” Auernheimer, utilizó la expresión “dropped docs” [difundir documentos personales] al hablar con un periodista de The New York Times en 2008 durante una entrevista sobre Sierra. Pero la palabra solo llegó a asociarse con su caso mucho más tarde, cuando “dox” entró en el discurso general, ya diluido para incluir simplemente el desenmascaramiento de individuos anónimos.

Desenmascarar una identidad puede tener consecuencias terribles para la persona afectada, en especial si el nombre completo está vinculado a información pública más sensible. Pero cuando el doxing incluye direcciones personales y números de la Seguridad Social, las consecuencias son, obviamente, mucho más graves. Un doxing puede arruinar tu historial crediticio y dejarte expuesto a amenazas mucho más directas: envío de cartas y paquetes a tu casa o, peor aún, agresiones, ya sea a manos de un acosador real o de la policía.

SWATting

Un dox puede convertirse en una agresión por delegación cuando deriva en un SWATting: utilizar el nombre y la dirección del objetivo para realizar una llamada falsa a emergencias que desencadene una operación del equipo SWAT en su domicilio. Como escribe Katherine Cross, “pueden acusar a la víctima del dox de fabricar una bomba, de retener rehenes, de tener un laboratorio de drogas, o de cualquier otra cosa que probablemente provoque una redada del SWAT en su casa. Este ha sido un uso popular del dox, especialmente en la comunidad gamer”.

Es comprensible que las víctimas de SWATting suelan mostrarse reacias a hablar públicamente. Pero esto distorsiona los comentarios mediáticos sobre el fenómeno. La mayoría de la cobertura en prensa generalista se ha centrado en hombres, sin aportar una razón clara para el SWATting. Mientras tanto, en enero de 2015, tres personas fueron víctimas de SWATting por parte de Gamergate, un fenómeno que, en esencia, es una campaña prolongada de acoso contra Zoe Quinn. El 3 de enero, la antigua casa de Grace Lynn, desarrolladora de videojuegos y crítica de Gamergate, fue objeto de un SWATting. El 9 de enero, Israel Galvez, también crítico de Gamergate, recibió la visita de la policía. Katherine Cross informó: “La falta de una respuesta más agresiva se debió a que Galvez había advertido a su comisaría local de que [un foro de Internet] lo había doxeado a él y a su familia”.

Por ahora, la cobertura mediática más visible sobre el SWATting se ha centrado en jóvenes que hacen SWATting a otros jóvenes, especialmente cuando el ataque se retransmite en directo. La narrativa habitual es la de espectadores de partidas en streaming que llaman a equipos SWAT para que irrumpan en casa del streamer. Así, la historia se enmarca como una serie de bromas extremas entre jugadores varones. Pero el SWATting también afecta a mujeres, como respuesta reactiva e ideológica contra un feminismo que algunos consideran “excesivo”.

En su documentación del fenómeno del doxing, Katherine Cross escribe: “Insisto en recordar al lector que todo esto se remonta a opiniones sobre videojuegos, a un odio hirviente hacia las feministas que juegan y escriben sobre ellos, y a una campaña de acoso que comenzó como un acto prolongado de violencia doméstica contra la desarrolladora Zoe Quinn por parte de un exnovio vengativo y abusivo”.

Doxear a mujeres

Bruce Schneier señala que el doxing existe desde 2001. Otros recuerdan haber visto el término en canales de IRC a mediados de los 2000, especialmente en contextos de represalia contra el periodista del New York Times John Markoff, quien había escrito un controvertido reportaje sobre el hacker Kevin Mitnick. Algunos consideran que Markoff contribuyó (o tuvo culpa) en la posterior detención y encarcelamiento de Mitnick. (La cuenta de correo del periodista fue comprometida en 1996). En 2011, se publicaron dox sobre HBGary Federal, una empresa que afirmaba poder identificar a miembros de Anonymous y LulzSec recopilando información de redes sociales. Publicar datos personales es la forma en que Internet se venga de quienes percibe como una amenaza, pero no es solo una represalia de fondo; también funciona como un mecanismo de vigilancia y control del propio Internet como espacio público.

A día de hoy, en las pocas ocasiones en que The New York Times ha mencionado “doxing” (y la única vez que ha mencionado “SWATting”), ninguna de las situaciones descritas involucra a mujeres. El aumento en el uso del término, como muestra un gráfico de Google Trends, está estrechamente relacionado con el auge de LulzSec y con el artículo de Adrian Chen sobre Michael Brutsch/Violentacrez. Los reportajes y piezas de tendencias sobre doxing y SWATting se centran sobre todo en hombres, incluso ahora, en un momento en que el acoso en línea contra mujeres recibe mayor atención mediática.

Sin embargo, existe un patrón claro y ampliamente documentado de utilizar el doxing para castigar a mujeres por ser visibles en Internet. El doxing es una táctica que los hackers han usado para “proteger” a otros hackers —por ejemplo, atacando al hombre que contribuyó al encarcelamiento de Mitnick, o a una empresa que buscaba desenmascararlos—. Es un modo de decir: “Somos de Internet, y no nos gustas.” Es un modo de decir: “No perteneces aquí.”

El doxing nació como una forma de represalia justiciera por parte de hackers contra quienes consideraban sus enemigos. Tiene menos sentido cuando se practica contra personas como Kathy Sierra, Anita Sarkeesian, Zoe Quinn y otras, salvo que se entienda la motivación como una misoginia profunda, una que afirma: estas mujeres no pertenecen a Internet. El doxing es una táctica de intimidación dentro de lo que sus autores perciben claramente como una guerra por los espacios en línea.

Al igual que el abuso verbal en línea, el doxing es una táctica para dominar la voz de Internet. Cada cual tiene su propia idea de lo que debe o no debe estar ahí —en otras palabras, de qué basura hay que sacar. En el caso de los misóginos, las mujeres son esa basura.

Con este contexto, quiero subrayar dos puntos sobre el doxing como fenómeno y por qué debe orientar las soluciones al acoso en línea.

En primer lugar, uno de los puntos más obvios y, sin embargo, más ignorados es que la anonimidad no es el problema. Es evidente que la anonimidad puede servir de escudo frente a esta variante extrema de abuso en línea. La responsable de Confianza y Seguridad de Twitter, Del Harvey, es de hecho una persona que opera bajo seudónimo porque, desde los 21 años, comenzó a colaborar con la organización Perverted Justice, que atrapaba depredadores en Internet haciéndose pasar por menores. Su trabajo llevó a personas a prisión, y su seudónimo es una de varias medidas para protegerse. En una entrevista con Forbes, Harvey afirmó: “Hago muchas cosas en mi vida para que sea difícil localizarme”.

Cuando se intenta frenar el abuso en línea, reducir el anonimato puede, de hecho, agravarlo. Toda política contra el acoso que pretenda “desenmascarar” a las personas no solo supone una amenaza para la libertad de expresión anónima —por ejemplo, en países con gobiernos represivos—, sino que es directamente contraproducente como medida antiacoso.

En segundo lugar, algo que también suele pasarse por alto es que las reformas normativas y legislativas que permitirían mitigar o limitar el doxing fueron propuestas hace casi diez años al Congreso por el Electronic Privacy Information Center (EPIC). EPIC logró ciertos avances, pero los daños que señaló han persistido. En este momento, cuando un tipo muy específico de acoso en línea está en plena efervescencia, sería oportuno impulsar una agenda reforzada de protección de la privacidad que retome directamente la iniciativa de EPIC de 2006 contra el pretexting —obtener información personal mediante engaños, como hacerse pasar por otra persona por teléfono.

En febrero de 2006, Marc Rotenberg, director ejecutivo de EPIC, presentó una declaración ante el Comité de Energía y Comercio de la Cámara, llamando la atención sobre el problema del pretexting. Rotenberg señaló que, en un caso ocurrido en New Hampshire (Remsburg v. Docusearch), el acosador de una mujer había contratado a un corredor de datos, que a su vez subcontrató a un investigador privado. El investigador utilizó pretexting, haciéndose pasar por la compañía de seguros de la mujer, y logró obtener su localización. La información fue entregada al acosador. Más tarde, él le disparó a la mujer y después se suicidó. “La disponibilidad de estos servicios representa riesgos graves para las víctimas de violencia doméstica y acoso”, afirmó Rotenberg en su declaración preparada. “No hay razón para que se puedan obtener estos registros mediante pretexting”.

Como resultado de estas audiencias, se aprobó una ley federal que prohíbe el pretexting para obtener los registros telefónicos personales de otra persona. Pero los riesgos que plantean los corredores de datos para las víctimas de violencia doméstica y acoso persisten. Las direcciones físicas están ampliamente disponibles a través de estos intermediarios. Una dirección puede estar a un simple clic en Google. Este es el método principal mediante el cual la gente es doxeada en Internet.

La naturaleza esencial del problema está vinculada a formas de violencia contra las mujeres como el acoso, las agresiones y la violencia de pareja. El doxing no es un problema de la Internet de basura en el mismo sentido que lo son las palabras o imágenes abusivas. Aunque las mismas medidas que pueden mitigar el abuso en general también pueden mitigar el doxing (por ejemplo, moderación adecuada de publicaciones con datos personales, creación de normas contra el doxing, reglas estrictas aplicadas en toda la plataforma), las consecuencias del doxing no pueden abordarse con las mismas estrategias. Si estas propuestas de política parecen insuficientes o débiles ante el tipo de acoso escandaloso que aparece en los medios, es porque no están pensadas para resolver por completo las formas más extremas de acoso en línea. Los extremos del acoso digital nacen de los mismos patrones de comportamiento que producen la constante y agotadora malicia dirigida contra las mujeres, pero no pueden abordarse con las mismas herramientas.

Una taxonomía del acoso

El acoso, como concepto, es un contenedor enorme, que abarca desde un simple tuit grosero hasta la policía derribando la puerta de tu casa. Para poder elaborar políticas razonables, ese contenedor debe analizarse y desglosarse, aunque todo siga formando parte del mismo conjunto. Las personas que son objeto de acoso, especialmente quienes pertenecen a grupos marginados, pueden interpretar un solo comentario de manera distinta a como lo haría un observador externo, porque lo reconocen como parte de un patrón más amplio.

El acoso existe en dos ejes simultáneamente: uno definido por el comportamiento y otro definido por el contenido. El primero es la mejor forma de comprender el acoso, pero el segundo es el que más atención ha recibido tanto en el discurso público como en los estudios académicos.

Cuando se analiza el acoso como contenido, nos acabamos fijando en las “amenazas de muerte” como un extremo del espectro y en los “mensajes molestos” en el otro. Así, el debate termina girando en torno a derechos civiles frente a libertad de expresión: ¿dónde está la línea entre comentarios ofensivos y peligro inminente? ¿entre una broma y una amenaza?

El comportamiento es una lente mejor y más útil para examinar el acoso. En un extremo del espectro conductual del acoso en línea encontramos el mensaje vitriólico lanzado al vuelo en mitad de la noche; en el otro, la filtración de números de la Seguridad Social, la publicación de fotografías privadas, el envío de equipos SWAT a direcciones físicas y las agresiones físicas. Decir que estos comportamientos están en el mismo espectro no significa que merezcan el mismo tipo de censura o castigo. Del mismo modo, los comentarios callejeros no merecen responsabilidad penal, pero para quienes los reciben forman parte de un mismo continuum de comportamientos sexistas —el constante sentimiento de derecho masculino sobre la atención de una mujer— que desemboca en agresiones y otras graves consecuencias físicas. Ver estos comportamientos uno al lado del otro no sirve tanto para determinar cómo castigarlos a posteriori, sino para aprender a diseñar entornos donde los objetivos del acoso se sientan seguros.

El contenido acosador y el comportamiento acosador se solapan, por supuesto. Las publicaciones en Internet son a la vez contenido y comportamiento. Pero cambiar de lente puede transformar por completo nuestra comprensión. “Alguien me ha llamado ‘zorra’ en su blog” es distinto de “Alguien lleva tres meses publicando en su blog cuánto me odia, cada día”. Ambas afirmaciones pueden describir la misma situación, pero una habla desde la perspectiva del contenido, y la otra desde la del comportamiento.

El contenido acosador puede dividirse a lo largo de su propio espectro, desde lo menos extremo hasta lo más extremo:

• Acoso sin amenaza: Acoso que no puede interpretarse como una amenaza. Que te llamen “zorra” o que te insulten con un término racial constituye acoso sin amenaza.

• Acoso con apariencia de amenaza: Acoso que no es abiertamente amenazante, pero que resulta ambiguamente amenazante hasta el punto de que un observador objetivo tendría dificultades para decidir, o que está claramente diseñado para infundir miedo en la persona destinataria manteniendo una negación plausible. Por ejemplo, “Ojalá alguien te raje el cuello” es acoso con apariencia de amenaza. También lo es enviar la imagen de una cruz ardiendo a una persona afroamericana.

• Acoso abiertamente amenazante: “Sé dónde vives; esta noche voy a matarte”.

El comportamiento acosador, por su parte, puede clasificarse de dos maneras: por inversión y por impacto. En la primera, el comportamiento se define por el grado de inversión que el acosador realiza en sus acciones.

• Acoso persistente: Es, en esencia, acecho: una persona actuando sola que persigue de forma insistente a una o varias personas, ya sea enviándoles mensajes horribles, publicando obsesivamente sobre su vida personal o incluso mandándoles correo físico o siguiéndolas en persona.

• Orquestación sostenida: La orquestación es acoso mediante “mano de obra colectiva”: reclutar a otras personas para acosar a alguien en una campaña sostenida. Puede surgir simplemente publicando un dox, o mediante mensajes diseñados para incitar a una audiencia a atacar a alguien por el motivo que sea.

• Acoso de baja intensidad por turba: Es el comportamiento de quienes se suman a una campaña sostenida, pero sin llegar a convertirse en orquestadores. Amplifican el acoso, pero no están obsesionados con la víctima. No acosarían a esa persona sin que el orquestador los estuviera azuzando.

• Acoso esporádico (drive-by): Una persona aleatoria comportándose de forma terrible una sola vez.

Cuando se clasifica por impacto, el comportamiento acosador se define por los efectos a largo plazo sobre la víctima. En esta clasificación, las categorías se solapan y se influyen mutuamente:

• Daño emocional: Puede ir desde un malestar leve hasta una angustia grave e incluso depresión.

• Daño económico: Atacar el trabajo de la víctima, hacerla inempleable manipulando los resultados de búsqueda de su nombre, publicar su número de la Seguridad Social y arruinarle el crédito.

• Daño personal: Agresión, agresión por intermediación (SWATting), vulneración de la privacidad de la víctima mediante doxing, pirateo u otros métodos.

Todas estas dimensiones se solapan por completo. Pero sostengo que, al separar estos aspectos, podemos entender mejor cómo deben diseñarse tanto los sistemas legales como los sistemas técnicos. Los sistemas legales deberían abordar las formas más extremas de acoso: el contenido abiertamente amenazante, el daño personal, ciertos tipos de daño económico y quizá incluso algunas formas de orquestación sostenida.

La arquitectura técnica de las plataformas, por el contrario, debería diseñarse para amortiguar el comportamiento acosador y proteger a las personas destinatarias del contenido hostil. Esto significa crear fricción técnica que dificulte organizar una campaña sostenida en la plataforma o mantener un acoso persistente. Por ejemplo: ¿y si, tras tu quinto tuit sin respuesta en una hora dirigido a alguien que no te sigue, apareciera un mensaje preguntando si realmente quieres enviar ese tuit?

También implica construir interfaces que transmitan una sensación de seguridad a quienes son objeto de acoso. El código nunca es neutral, y las interfaces pueden comunicar muchas cosas a los usuarios. Por ejemplo, ¿qué habría pasado si Caroline Criado-Perez hubiese podido pulsar un “botón de pánico”, que le mostrara un mensaje informando de que el equipo de Twitter Trust & Safety estaba revisando el caso y, mientras tanto, ocultara los mensajes de desconocidos?

He utilizado ejemplos específicos de Twitter porque quiero que quede claro que estas decisiones deben adaptarse a cada plataforma. Aunque las plataformas pueden aprender unas de otras y adoptar métodos similares, no existe una táctica universal. Lo importante es entender que simplemente borrar o filtrar contenido ofensivo no es el objetivo final. La eliminación puede desalentar a los acosadores y proporcionar seguridad a quien es acosado, pero es solo una de las herramientas posibles.

Sobre la moderación de contenidos en las redes sociales

Reconozco que hay una buena razón por la que el debate se centra en el contenido y no en el comportamiento. Es porque la mayoría de las plataformas de redes sociales de hoy funcionan así: priorizan el contenido por encima del comportamiento.

Los informes de abuso suelen examinarse de forma aislada. En WIRED, en 2014, Adrian Chen describió el día a día de un moderador de contenido en Filipinas, que revisaba miles de denuncias con tal rapidez que Chen, mirando por encima de su hombro, apenas tenía tiempo de registrar qué aparecía en cada foto.

La moderación actual —a menudo realizada por contratistas estadounidenses o externalizada a otros países— está diseñada como una cadena de montaje: tareas repetitivas, reglas universales, decisiones rápidas. (Que realmente se logre coherencia y eficiencia es otra cuestión). Con semejante volumen, estos equipos no pueden actuar como jueces: necesitan reglas simples. Seguir patrones de comportamiento a lo largo del tiempo o evaluar contextos complejos exige un tiempo y una energía que simplemente no tienen.

¿Significa eso que es económica o técnicamente imposible incluir patrones de comportamiento en la moderación? En absoluto. Pero lo esencial es que, incluso si nunca cambiara este enfoque hacia reglas claras basadas en contenido, mirar el acoso como comportamiento —como la verdadera fuente del daño— es útil. Las reglas claras deben diseñarse para atajar el comportamiento, aunque su aplicación inmediata sea sobre el contenido.

Más allá de borrar

Lo peculiar de la moderación actual en las grandes plataformas es que se centra casi exclusivamente en borrar y prohibir: eliminar contenido o expulsar usuarios.

Sin embargo, la moderación no consiste solo en borrar y prohibir, aunque esas opciones existan. Hay toda una gama de opciones de gestión del contenido a posteriori, algunas de ellas inspiradas en el artículo de James Grimmelmann, “The Virtues of Moderation”, que propone una taxonomía útil para entender comunidades en línea y su moderación.

- Borrado: No necesita explicación.

- Filtrado: El filtrado hace que algo sea difícil de ver, pero no lo elimina. Puede ser un filtrado específico para cada usuario (como el algoritmo del Newsfeed de Facebook), o un filtrado a escala de plataforma: en Reddit, los comentarios con puntuación negativa se muestran atenuados y minimizados, aunque pueden desplegarse si se desea. También puede ser filtrado desde el lado del usuario: por ejemplo, bloquear a otras personas.

- Edición: La edición altera el contenido, pero no necesariamente lo elimina por completo. Editar puede aprovechar el contenido de forma productiva. Si una publicación se considera valiosa, pero contiene partes problemáticas que infringen las normas, la edición puede eliminar los fragmentos objetables. Por ejemplo, si un periodista publica en redes sociales una serie de documentos obtenidos mediante solicitudes de información pública y uno de esos documentos revela accidentalmente la dirección física de una persona, la mejor respuesta sería editar —si es posible— para eliminar la dirección, en lugar de expulsar al periodista o borrar su publicación. En la práctica, la edición puede rozar el borrado. Véanse, por ejemplo, foros o hilos de comentarios donde los moderadores sustituyen publicaciones enteras por mensajes en mayúsculas de tono humorístico, como “SOY UN BEBÉ LLORÓN”.

- Anotación: Se añade información adicional. Grimmelmann pone como ejemplos el sistema de reseñas de compradores y vendedores de eBay, el botón “Me gusta” de Facebook y las reseñas de Amazon. En muchos foros, las publicaciones están anotadas con valoraciones (que indican si un mensaje es bueno o malo según los usuarios). La anotación puede acompañar al filtrado o al bloqueo. Usada de determinada forma en algunas plataformas, también podría permitir que los usuarios supieran si alguien es conocido por tener un comportamiento abusivo.

- Amplificación y disminución: Es un híbrido entre anotación y filtrado. Técnicamente, el botón “Me gusta” de Facebook entra en esta categoría (las publicaciones con más “me gusta” tienden a aparecer más en los feeds). Otro ejemplo es el sistema de votos positivos y negativos de Reddit o Quora. La decisión de interfaz de atenuar o “grisar” las respuestas con muchos votos negativos en Reddit es una forma de disminución. Yahoo Answers permitía al usuario que hacía la pregunta escoger la “mejor” respuesta, que luego ascendía a la parte superior. En los foros SomethingAwful existía un “Goldmine” (donde se archivaban los hilos buenos) y un “Gaschamber” (donde se relegaban los hilos malos).

Estas son las medidas que pueden aplicarse al contenido. Pero los procesos a posteriori también pueden dirigirse a usuarios a causa de su comportamiento:

- Expulsión: La cuenta de un usuario queda desactivada.

- Bloqueo por IP: Se bloquea la dirección de protocolo de Internet desde la que publica el usuario. Los bloqueos por IP pueden esquivarse y tener efectos indeseados (por ejemplo, bloquear a un estudiante que escribe desde la red de su universidad puede impedir publicar a muchas otras personas). Aun así, algunas plataformas han considerado que, en ciertos casos, vale la pena aplicarlos y que pueden ser eficaces.

- Suspensión: Se supone que es una expulsión temporal. Puede ser una suspensión por un periodo fijo de tiempo, o estar condicionada a que el usuario realice determinadas acciones.

- Procesos de responsabilidad: Esta es una nueva forma de procesos de moderación a posterioridirigidos a los usuarios, y ofrece un enorme potencial. Un proceso de responsabilidad aparta a un usuario no solo para frenar su comportamiento, sino también para rehabilitarlo. Laura Hudson informó sobre cómo el juego en línea League of Legends creó un proceso de responsabilidad exitoso:

“League of Legends lanzó un sistema disciplinario llamado el Tribunal, en el que un jurado formado por otros jugadores vota sobre los casos reportados de mal comportamiento. Con la facultad de emitir desde advertencias por correo electrónico hasta expulsiones de larga duración, los usuarios han emitido decenas de millones de votos sobre el comportamiento de otros jugadores. Cuando Riot [la empresa] pidió a su personal que auditara los veredictos, descubrió que los empleados coincidían unánimemente con los usuarios en casi el 80% de los casos. Y este sistema no solo castiga a los jugadores: también los rehabilita, devolviendo a buen comportamiento a más de 280.000 jugadores sancionados. Riot recibe habitualmente disculpas de usuarios que han pasado por el Tribunal, diciendo que no habían entendido lo ofensivo que era su comportamiento hasta que alguien se lo señaló. Otros incluso han solicitado ser puestos en un modo de chat restringido, que limita el número de mensajes que pueden enviar durante las partidas, obligándolos a elegir entre comunicarse con sus compañeros o acosar a otros.”

Las motivaciones de quienes acosan siguen siendo poco comprendidas. Puede que los acosadores sean simplemente personas desorientadas. Puede también que sean sociópatas irrecuperables. (Puede que existan ambos casos.) Pero los procesos de responsabilidad funcionan porque no solo ofrecen a la gente una oportunidad de cambiar genuinamente de actitud: también les dejan claro, de manera visible, que su comunidad no respalda ese comportamiento. Un usuario no tiene por qué experimentar un cambio moral profundo para decidir ajustarse a las normas que se están haciendo cumplir.

Qué ocurre antes: fijar normas

Todos los métodos anteriores de moderación ex post operan también a nivel ex ante: cuando los usuarios ven cómo se modera su comunidad, tienden a conformarse para evitar ser moderados. (En muchos lugares, cuando un usuario nuevo comete un error o publica algo indeseable o trivial, se le dice de forma hostil que “observe más” o lurk more: en esencia, se le pide que absorba las normas antes de aportar contenido.)

Pero también pueden fijarse normas fuera de la acción ex post sobre el contenido ofensivo. Por ejemplo:

- Articulación: Consiste simplemente en establecer reglas claras. En un artículo titulado “If Your Website’s Full of Assholes, It’s Your Fault”, Anil Dash sostiene que las políticas comunitarias o códigos de conducta deben ser “breves, escritos en un lenguaje sencillo, fácilmente accesibles y formulados de forma flexible, de modo que la gente no se dedique a buscar resquicios en las reglas para justificarse cuando las incumplen”.

- Refuerzo positivo: La moderación puede mostrar a los usuarios qué tipos de publicaciones son inaceptables, pero también puede señalar cuáles son valiosas y dignas de emular. Grimmelmann pone como ejemplo que los moderadores seleccionen “publicaciones nuevas y destacadas”. Reddit ofrece un escaparate llamado “best of Reddit”, y también permite que los usuarios se “doren mutuamente” (gild), es decir, comprar una cuenta premium para un usuario cuyo aporte consideran excelente. Las publicaciones “doradas” se anotan con una estrella dorada.

- El aura de responsabilidad: La buena moderación ex post implica que se preserve un aura de responsabilidad dentro de la comunidad: es decir, que existan consecuencias para las conductas indebidas. Pero también hay consideraciones ex ante. Anil Dash sugiere obligar a los usuarios a tener “identidades responsables”, lo que podría significar nombres reales, o simplemente mantener un pseudónimo constante a lo largo del tiempo.

El aura de responsabilidad no solo va en una dirección. Si los usuarios sienten que la plataforma es responsable ante ellos, estarán más comprometidos con que la plataforma funcione bien y serán menos proclives a degradarla. Casi todas las plataformas utilizan blogs para informar a la comunidad sobre cambios en las políticas. Estos blogs suelen emplear un lenguaje que indica que la plataforma “escucha” o que “se preocupa”. Es algo bastante pro forma —¿puedes imaginar una plataforma que admita abiertamente que su prioridad es satisfacer a los accionistas?—. Lo interesante es cómo algunas plataformas y comunidades han adoptado estructuras de gobernanza orientadas al usuario. Wikipedia es un ejemplo interesante, pero un caso especialmente llamativo (aunque quizá no replicable) es el del juego EVE Online, que cuenta con un Council of Stellar Management (CSM), compuesto por representantes elegidos por su base de usuarios. El CSM es invitado regularmente a viajar a la sede de la empresa para reunirse con el personal y discutir el juego y sus características.

Fomentar la implicación de los usuarios en su comunidad —lo que Grimmelmann denomina “sentido de pertenencia y compromiso con el bien de la comunidad”— depende tanto de la moderación como de la arquitectura. No es solo algo emocional: también es un problema técnico, ya que el código de la plataforma debe ser capaz de detener o disuadir adecuadamente a los malos actores que intentan crear cuentas nuevas sin cesar o saturar la plataforma con mensajes no deseados. Es un proceso cíclico: cuando la gente se siente implicada en la comunidad, esta se auto-regula y hace cumplir las normas; pero cuando los malos actores nunca son expulsados o pueden reproducir su presencia a un ritmo alarmante (suplantación múltiple), la confianza y la implicación de la comunidad se evaporan.

* Sobre la autora:

Sarah Jeong es periodista y jurista. Escribe sobre tecnología, política y derecho, con artículos en The Verge, Forbes, The Guardian, Slate y WIRED. Se graduó en la Facultad de Derecho de Harvard en 2014. Como estudiante de derecho, editó el Harvard Journal of Law & Gender y trabajó en la Electronic Frontier Foundation y en el Berkman Center for Internet & Society. Es coautora de Five Useful Articles, un popular boletín sobre derecho de autor.

* Imagen: Extruded Blob #1 (de la serie Daily Sketches), de Zach Lieberman.

* Fuente: “The Internet Is Garbage” y “On Harassment”, capítulos del libro The Internet Of Garbage(Forbes, 2015), de Sarah Jeong.

Nota:

[1] Cerda decapitada